Chapitre 14 ANOVA Factorielle

Au cours des derniers chapitres, nous avons fait pas mal de choses. Nous avons examiné les tests statistiques que vous pouvez utiliser lorsque vous avez une variable prédictive nominale à deux groupes (c.-à-d. le test t, chapitre 11) ou à trois groupes ou plus (p. ex. ANOVA à un facteur, chapitre 13). Le chapitre sur la régression (chapitre 12) a introduit une nouvelle idée puissante, à savoir la construction de modèles statistiques avec de multiples variables prédicteurs continues utilisées pour expliquer une seule variable résultat. Par exemple, un modèle de régression pourrait être utilisé pour prédire le nombre d’erreurs qu’un élève commet dans un test de compréhension de la lecture en fonction du nombre d’heures qu’il a étudiées pour le test et de son résultat à un test de QI normalisé.

Le but de ce chapitre est d’étendre l’idée d’utiliser plusieurs variables prédictrices dans le cadre de l’analyse de variance. Supposons, par exemple, que nous voulions utiliser le test de compréhension de la lecture pour mesurer le rendement des élèves dans trois écoles différentes, et que nous soupçonnons que les filles et les garçons se développent à des rythmes différents (et que l’on s’attendrait donc à ce qu’ils aient en moyenne des performances différentes). Chaque élève est classé de deux façons différentes : en fonction de son sexe et en fonction de son école. Ce que nous aimerions faire, c’est d’analyser les résultats de compréhension de la lecture en fonction de ces deux variables de regroupement. L’outil pour ce faire est appelé ANOVA factorielle. Toutefois, comme nous avons deux variables de regroupement, nous l’appelons parfois analyse de variance bifactorielle, contrairement aux analyses de variance à un facteur que nous avons effectuées au chapitre 13.

14.1 ANOVA Factorielle 1 : des plans équilibrés, pas d’interactions

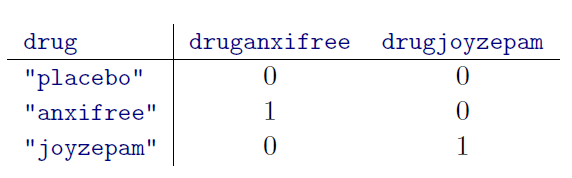

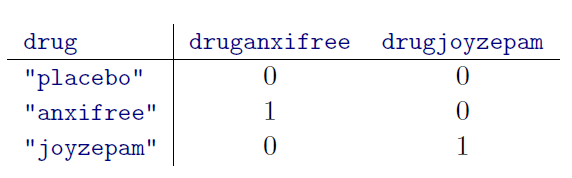

Lorsque nous avons discuté de l’analyse de la variance au chapitre 13, nous avons supposé un plan expérimental assez simple. Chaque personne fait partie d’un groupe parmi d’autres et nous voulons savoir si ces groupes ont des scores moyens différents pour une variable résultats. Dans la présente section, je traiterai d’une catégorie plus large de plans expérimentaux appelés plans factoriels, dans lesquels nous avons plus d’une variable de groupement. J’ai donné ci-dessus un exemple de la façon dont ce genre de plan pourrait être réalisé. Nous avons vu un autre cas de figure au chapitre 13, dans lequel nous examinions l’effet de différents médicaments sur le l’amélioration de l’humeur ressenti par chaque personne. Dans ce chapitre, nous avons trouvé un effet important du médicament, mais à la fin du chapitre, nous avons également effectué une analyse pour voir s’il y avait un effet de la thérapie. Nous n’en avons pas trouvé, mais il y a quelque chose d’un peu inquiétant à essayer d’effectuer deux analyses distinctes pour prédire la même variable résultat. Peut-être qu’il y a un effet de la thérapie sur le gain d’humeur, mais nous n’avons pas pu le trouver parce qu’il était « caché » par l’effet du médicament? En d’autres termes, nous voulons effectuer une analyse unique qui inclut à la fois le médicament et la thérapie comme prédicteurs. Pour cette analyse, chaque personne est classée selon le médicament qu’on lui a administré (un facteur à 3 niveaux) et la thérapie qu’elle a reçue (un facteur à 2 niveaux). C’est ce que nous appelons un plan factoriel 3 x 2.

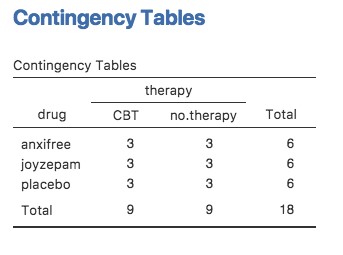

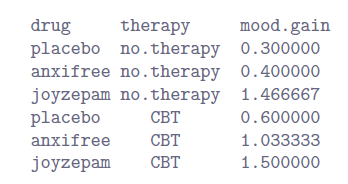

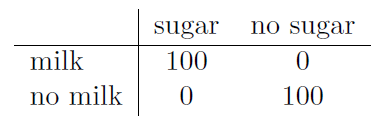

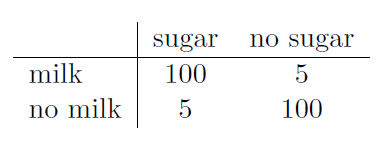

Si l’on croise les données sur les médicaments par traitement, en utilisant l’analyse « Frequencies » - « Contingency Tables » de Jamovi (voir la section 6.1), on obtient le tableau présenté à la Figure 14‑1.

Figure 14‑1 : Tableau de contingence Jamovi du drug par therapy

Comme vous pouvez le constater, non seulement nous avons des participants correspondant à toutes les combinaisons possibles des deux facteurs, ce qui indique que notre plan est complètement croisé121, mais il s’avère qu’il y a un nombre égal de personnes dans chaque groupe. En d’autres termes, nous avons un plan équilibré. Dans cette section, je parlerai de la façon d’analyser les données à partir de plans équilibrés, puisque c’est le cas le plus simple. L’histoire des plans déséquilibrées est assez fastidieuse, nous allons donc la mettre de côté pour l’instant.

14.1.1 Quelles hypothèses vérifions-nous ?

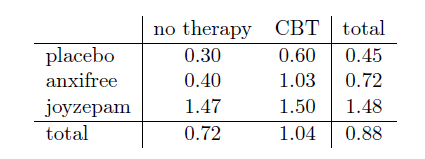

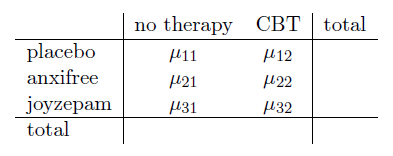

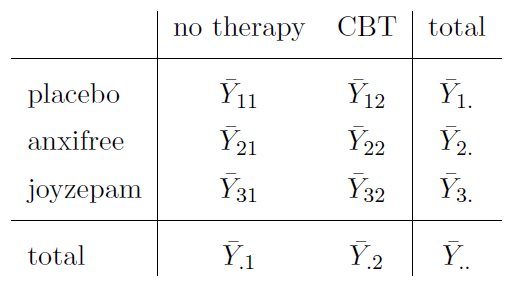

Comme l’analyse de variance à un facteur, l’analyse de variance factorielle est un outil permettant de tester certains types d’hypothèses sur les moyennes de population. Un bon point de départ serait donc d’être explicite sur ce que sont réellement nos hypothèses. Cependant, avant même d’en arriver là, il est vraiment utile d’avoir une notation claire et simple pour décrire les moyennes de la population. Étant donné que les observations sont classées selon deux facteurs différents, il existe un grand nombre de moyennes auxquels on peut s’intéresser. Pour voir cela, commençons par penser à tous les échantillons que l’on peut calculer pour ce type de plan. Tout d’abord, il y a l’idée évidente que nous pourrions nous intéresser à cette liste de moyennes de groupe :

Ce tableau présente une liste des moyennes de groupe pour toutes les combinaisons possibles des deux facteurs (p. ex. les personnes qui ont reçu le placebo et aucune thérapie, les personnes qui ont reçu le placebo en recevant la TCC (=CBT), etc.) Il est utile d’organiser tous ces chiffres, ainsi que les moyennes marginales et générales, dans un tableau unique qui ressemble à celui-ci :

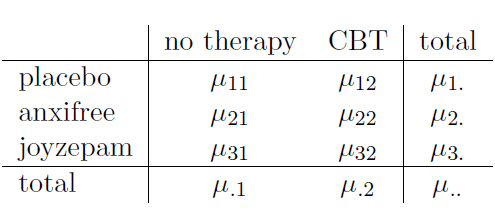

Chacune de ces moyennes correspond bien sûr à un échantillon de statistiques. C’est une quantité qui se rapporte aux observations précises que nous avons faites dans notre étude. Ce que nous voulons déduire, ce sont les paramètres correspondants de la population. C’est-à-dire, les vraies moyennes telles qu’elles existent au sein d’une population plus large. Ces moyennes de population peuvent aussi être organisées dans un tableau similaire, mais nous aurons besoin d’une petite notation mathématique pour le faire. Comme d’habitude, j’utiliserai le symbole µ pour désigner une moyenne de population. Cependant, parce qu’il y a beaucoup de moyennes différentes, j’utiliserai des indices pour les distinguer.

Voici comment fonctionne la notation. Notre tableau est défini en fonction de deux facteurs. Chaque ligne correspond à un niveau différent de facteur A (dans ce cas-ci, drug) et chaque colonne correspond à un niveau différent de facteur B (dans ce cas, therapy). Si nous indiquons par R, le nombre de lignes dans le tableau, et C, le nombre de colonnes, nous pouvons nous référer à cela comme une ANOVA factorielle RxC. Dans ce cas, R = 3 et C = 2. Nous utiliserons des lettres minuscules pour faire référence à des lignes et colonnes spécifiques, de sorte que µrc se réfère à la moyenne de population associée au r-ième niveau du facteur A (c’est-à-dire le numéro de ligne r) et au c-ième niveau du facteur B (numéro de colonne c).122 Ainsi, les moyennes de la population sont maintenant écrites comme ceci :

Bien, qu’en est-il des cases restantes ? Par exemple, comment décrire le gain d’humeur moyen dans l’ensemble de la population (hypothétique) qui pourraient recevoir du Joyzepam dans le cadre d’une expérience comme celle-ci, qu’elles aient été ou non en thérapie ? Nous utilisons la notation « point » pour l’exprimer. Dans le cas de Joyzepam, notez qu’il s’agit de la moyenne associée à la troisième ligne du tableau. C’est-à-dire que nous calculons la moyenne sur deux moyennes cellules (c.-à-d. µ31 et µ32). Le résultat de ce calcul de la moyenne est appelé moyenne marginale et, dans ce cas, il s’agit de µ3.. La moyenne marginale de la TCC correspond à la moyenne de la population associée à la deuxième colonne du tableau ; nous utilisons donc la notation µ.2 pour la désigner. La moyenne générale est désignée par µ.. parce qu’il s’agit de la moyenne obtenue en moyennant (en marginalisant123) sur les deux. Ainsi, notre tableau complet des moyennes de population peut être écrit de la façon suivante :

Maintenant que nous avons cette notation, il est facile de formuler et d’exprimer certaines hypothèses. Supposons que le but est de découvrir deux choses. Premièrement, le choix du médicament a-t-il un effet sur l’humeur ? Deuxièmement, la TCC a-t-elle un effet sur l’humeur ? Ce ne sont pas les seules hypothèses que nous pourrions formuler, bien sûr, et nous verrons un exemple très important d’un autre type d’hypothèse à la section 14.2, mais ce sont les deux hypothèses les plus simples à vérifier, et nous allons donc commencer par là. Considérez le premier test. Si le médicament n’a pas d’effet, on s’attendrait à ce que tous les moyennes de la rangée soient identiques, n’est-ce pas ? Voilà donc notre hypothèse nulle. D’un autre côté, si le médicament a de l’importance, il faut s’attendre à ce que les moyens de cette rangée soient différents. Formellement, nous écrivons nos hypothèses nulles et alternatives en termes d’égalité des moyennes marginales :

Hypothèse nulle, H0: Les moyennes en ligne sont les mêmes, c.-à-d. \(\mu_{1}=\mu_{2}=\mu_{3}\) Hypothèse alternative, H1 : La moyenne d’au moins une ligne est différente.

Il convient de noter qu’il s’agit exactement des mêmes hypothèses statistiques que celles que nous avons formulées lorsque nous avons effectué une analyse de variance à un facteur sur ces données au chapitre 13. A l’époque, j’utilisais la notation \(\mu_P\) pour faire référence au gain d’humeur moyen pour le groupe placebo, \(\mu_{A}\) et \(\mu_{J}\) correspondant à la moyenne du groupe pour les deux médicaments, et l’hypothèse nulle était \(\mu_{P} =\mu_{A} =\mu_{J}\). Nous parlons donc en fait de la même hypothèse, c’est juste que l’analyse de variance plus compliquée exige une notation plus prudente en raison de la présence de multiples variables de groupement, c’est pourquoi nous parlons maintenant de cette hypothèse comme de\(\mu_{.1}=\mu_{.2}=\mu_{.3}\). Cependant, comme nous le verrons plus loin, bien que l’hypothèse soit identique, le test de cette hypothèse est subtilement différent du fait que nous reconnaissons maintenant l’existence de la deuxième variable de groupement.

En parlant de l’autre variable de groupement, vous ne serez pas surpris de découvrir que notre deuxième test d’hypothèse est formulé de la même façon. Cependant, puisqu’il s’agit de la thérapie psychologique plutôt que du médicament, notre hypothèse nulle correspond maintenant à l’égalité des moyennes en colonne :

Hypothèse nulle, H0: Les moyennes en colonne sont les mêmes, c.-à-d. \(\mu_{.1}=\mu_{.2}\)

Hypothèse alternative, H1: Les moyennes des colonnes sont différentes, c-à-d. \(\mu_{.1}\neq\mu_{.2}\)

14.1.2 Réalisation de l’analyse dans Jamovi

Les hypothèses nulles et alternatives que j’ai décrites dans la dernière section devraient vous sembler terriblement familières. Il s’agit essentiellement des mêmes hypothèses que celles que nous avons testées dans nos analyses de variance à un facteur plus simples au chapitre 13. Vous vous attendez donc probablement à ce que les tests d’hypothèse utilisés dans l’analyse de variance factorielle soient essentiellement les mêmes que le test F du chapitre 13. Vous vous attendez à voir des références à des sommes de carrés (SS), des carrés moyens (MS), des degrés de liberté (df), et finalement une statistique F que nous pouvons convertir en une valeur p, n’est-ce pas ? Eh bien, vous avez tout à fait raison. A tel point que je vais m’écarter de mon approche habituelle. Tout au long de ce livre, j’ai généralement pris l’approche de décrire la logique (et dans une certaine mesure les aspects mathématiques) qui sous-tend une analyse particulière d’abord et seulement ensuite introduire l’analyse dans Jamovi. Cette fois, je vais le faire dans l’autre sens et vous montrer comment le faire en Jamovi d’abord. La raison en est que je veux souligner les similitudes entre le simple outil ANOVA à un facteur dont nous avons parlé au chapitre 13, et l’approche plus complexe que nous allons utiliser dans ce chapitre.

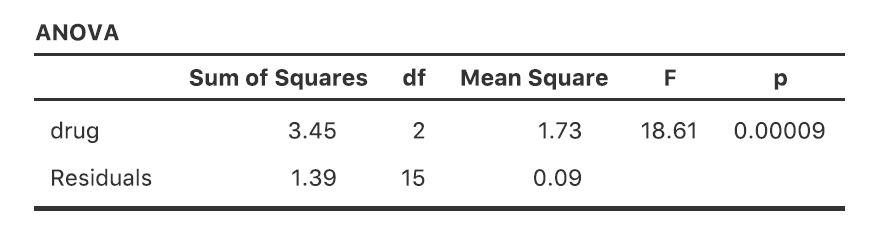

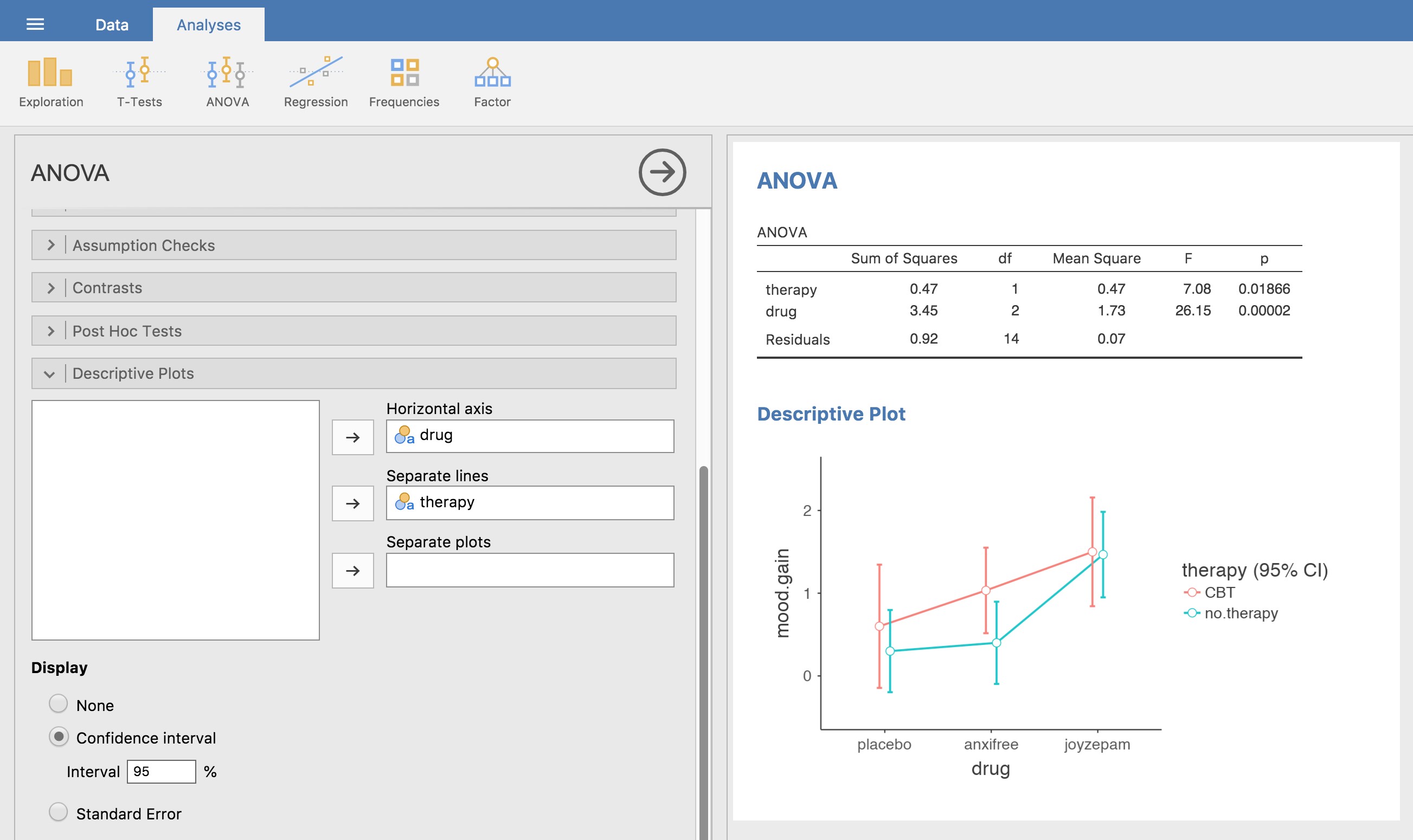

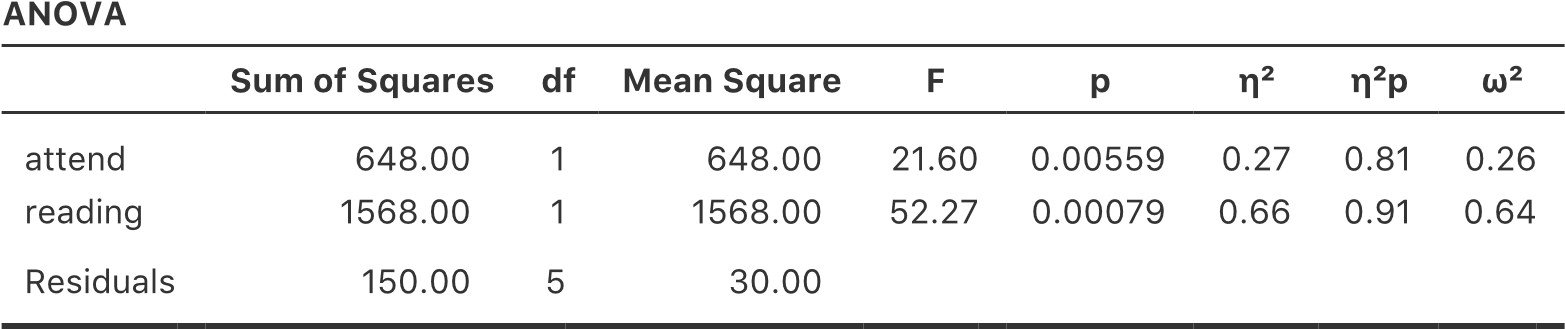

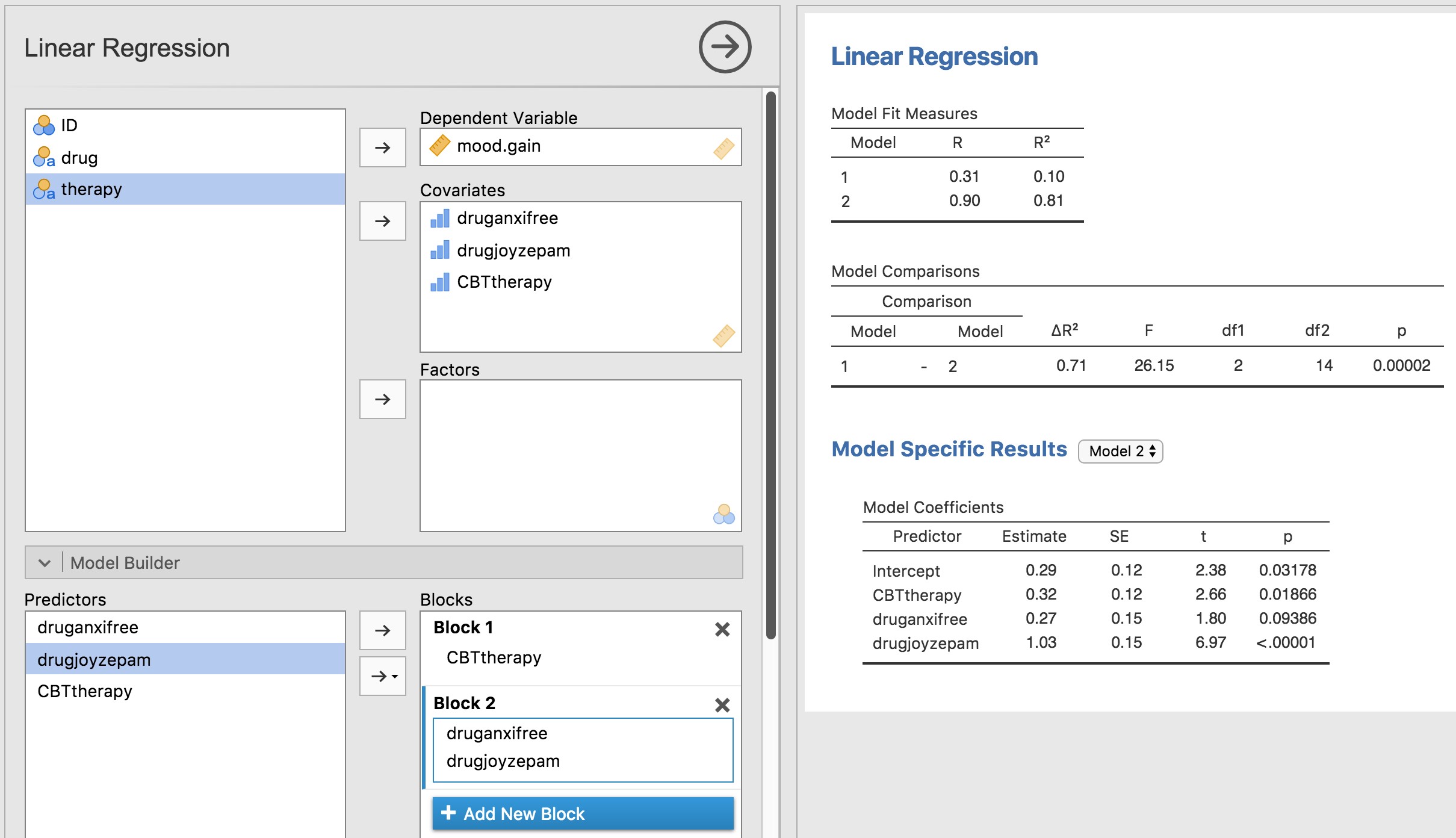

Si les données que vous essayez d’analyser correspondent à un plan factoriel équilibré, l’analyse de la variance est facile. Pour voir à quel point c’est facile, commençons par reproduire l’analyse originale du chapitre 13.Au cas où vous l’auriez oublié, pour cette analyse, nous n’utilisions qu’un seul facteur (c.-à-d. drug) pour prédire notre variable de résultat (c.-à-d. mood.gain), et nous avons obtenu les résultats présentés à la Figure 14‑2.

Figure 14‑2 : ANOVA à un facteur de mood.gain par drug avec Jamovi

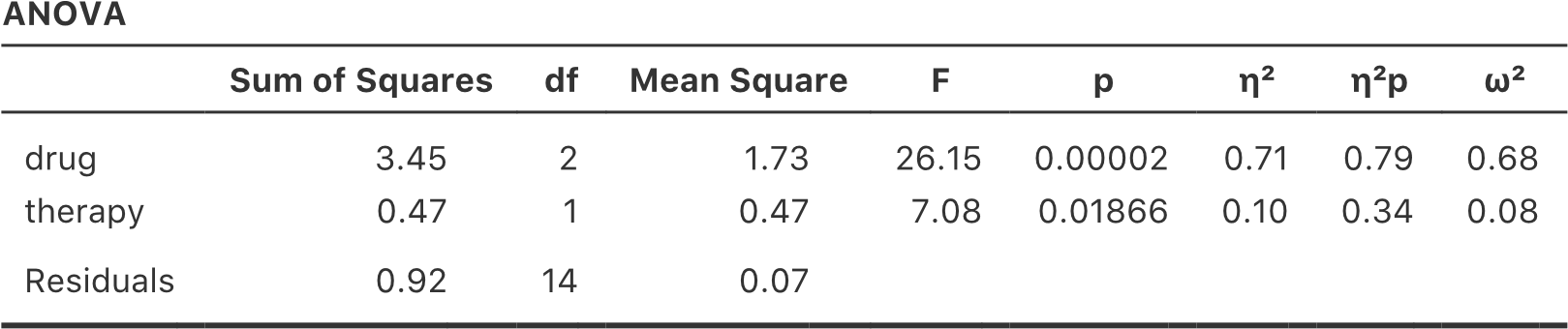

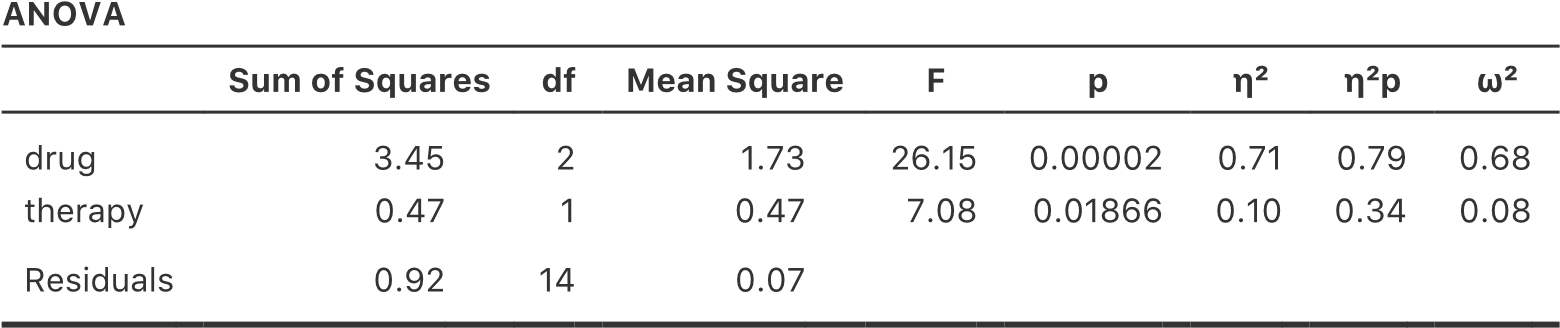

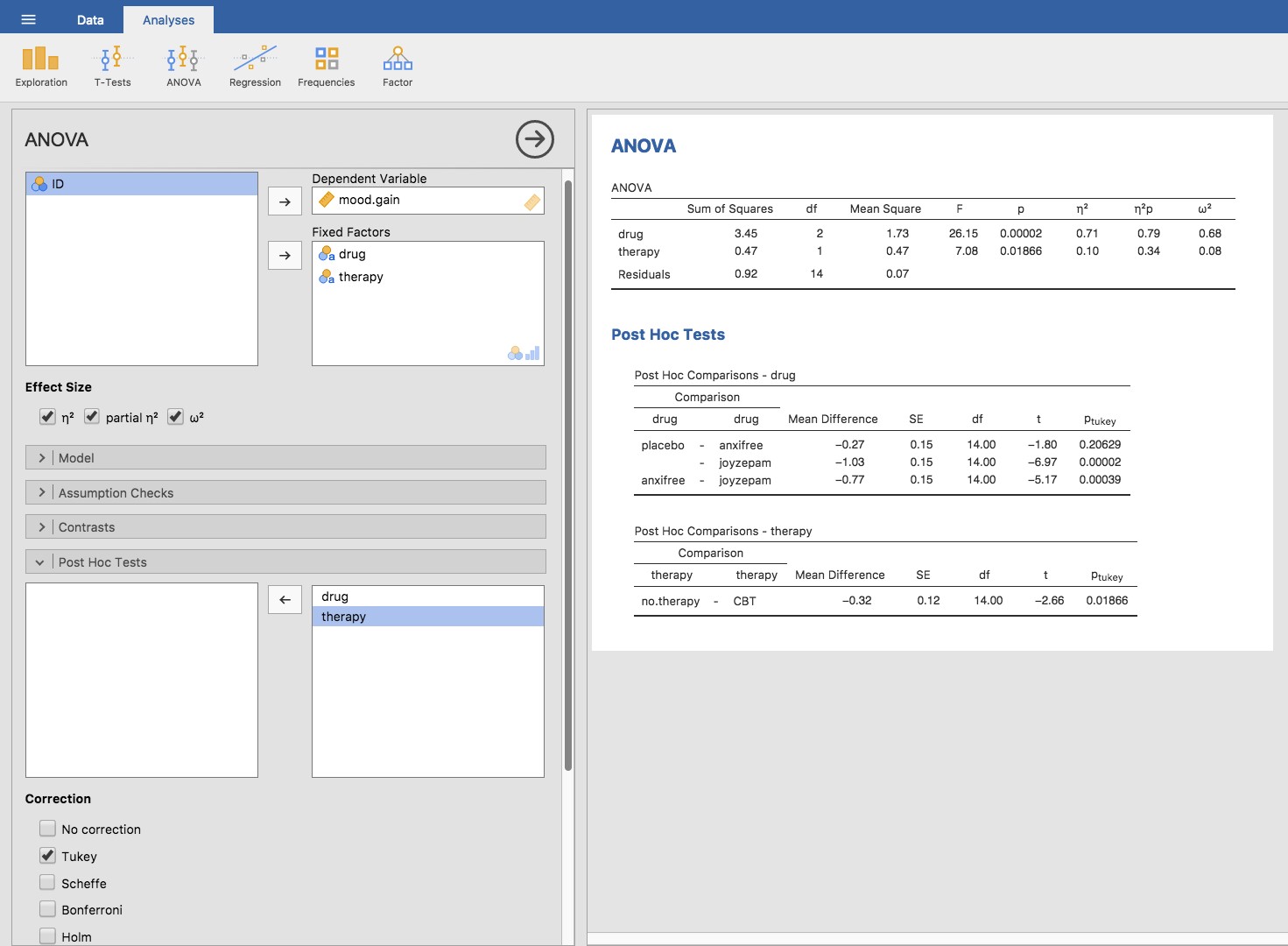

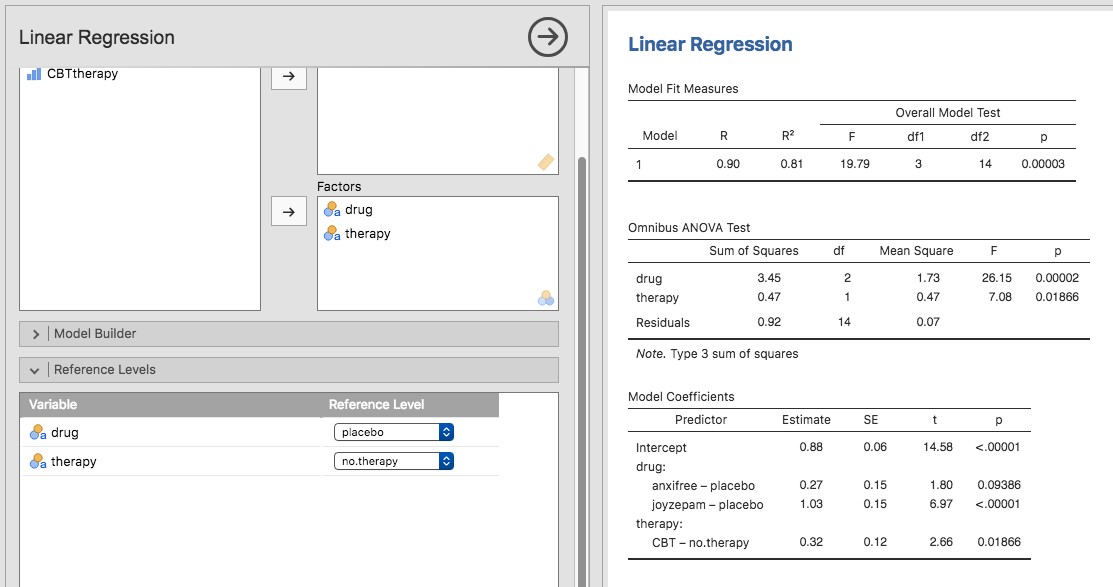

Maintenant, supposons que je sois aussi curieux de savoir si la therapy a une relation avec le mood.gain. A la lumière de ce que nous avons vu dans notre discussion sur la régression multiple au chapitre 12, vous ne serez probablement pas surpris qu’il nous suffise d’ajouter la therapy comme deuxième « Fixed Factor » dans l’analyse, voir la Figure 14‑3.

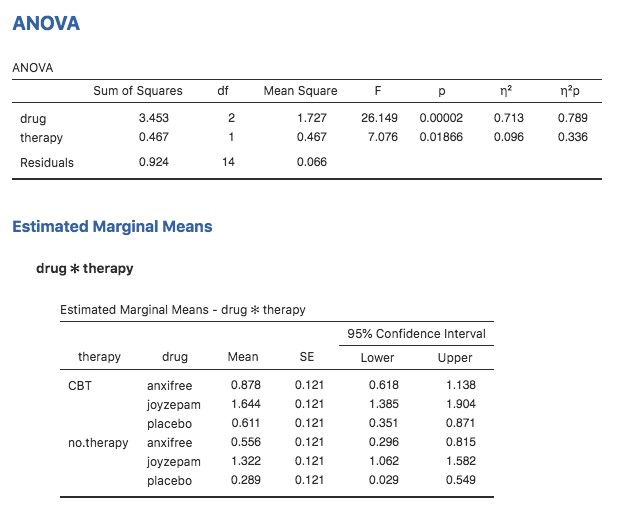

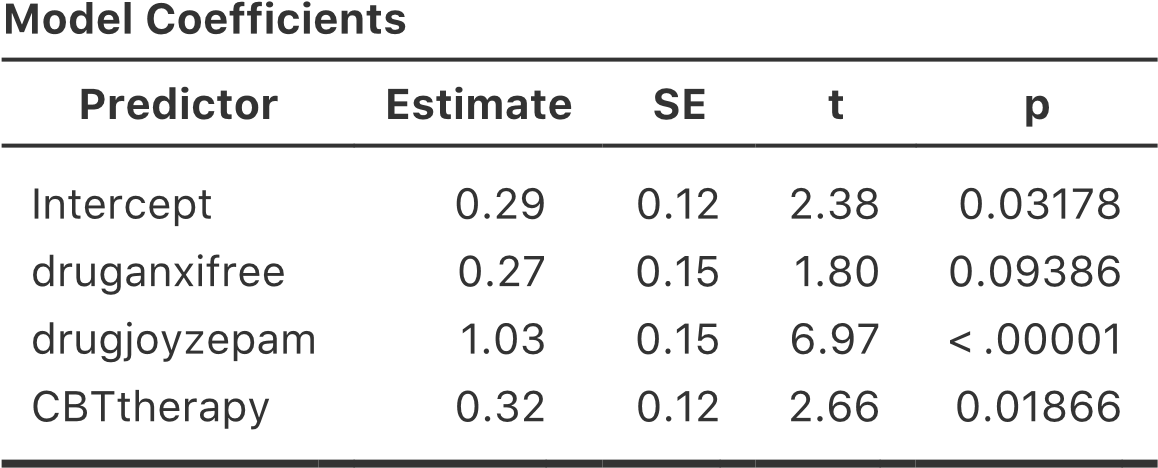

Cette sortie est assez simple à lire aussi. La première ligne du tableau indique la somme des carrés (SS) entre les groupes associés au facteur drug, ainsi que la valeur correspondante aux df inter groupes. Il calcule également un carré moyen (MS), une statistique F et une valeur p.

Figure 14‑3 Anova à deux facteurs dans Jamovi pour mood.gain par drug et therapy

Nous avons également une ligne correspondant au facteur therapy et une ligne correspondant aux résidus (c.-à-d. la variation intragroupe).

Non seulement toutes les quantités individuelles sont assez familières, mais les relations entre ces différentes quantités sont restées inchangées, tout comme nous l’avons vu avec l’ANOVA à un facteur. Notez que le carré moyen est calculée en divisant SS par le df correspondant. C’est-à-dire qu’il est toujours vrai que qu’il s’agisse de drug, de therapy ou des résidus.

\[ MS = \frac{\text{SS}}{\text{df}} \]

Pour le voir, ne nous inquiétons pas de la façon dont les sommes des carrés sont calculées. Au lieu de cela, prenons pour acquis que Jamovi a calculé correctement les valeurs SS, et essayons de vérifier que tous les autres nombres ont un sens. Tout d’abord, notons que pour le facteur drug, si on divise 3,45 par 2 et on obtient un carré moyen de 1,73. Pour le facteur therapy, il n’y a qu’un seul degré de liberté, donc nos calculs sont encore plus simples : diviser 0,47 (la valeur SS) par 1 nous donne un résultat de 0,47 (la valeur de MS).

En ce qui concerne les statistiques F et les valeurs p, notons que nous en avons deux de chaque, l’une correspondant au facteur drug et l’autre au facteur therapy. Peu importe de laquelle il s’agit, la statistique F est calculée en divisant le carrée moyen associé au facteur par le valeur carré moyen associé aux résidus. Si nous utilisons « A » comme notation abrégée pour désigner le premier facteur (facteur A ; dans ce cas, drug) et « R » comme notation abrégée pour désigner les résidus, alors la statistique F associée au facteur A est appelée FA, et est calculée comme suit :

\[ F_{A} = \frac{\text{MS}_{A}}{\text{MS}_{R}} \]

et une formule équivalente existe pour le facteur B (c.-à-d. therapy). Notez que cette utilisation de « R » pour parler des résidus est un peu gênante, puisque nous avons également utilisé la lettre R pour faire référence au nombre de lignes dans le tableau, mais j’utiliserai « R » seulement pour désigner les résidus dans le contexte de SSR et MSR, donc j’espère que cela ne sera pas trop confus. Quoi qu’il en soit, pour appliquer cette formule au facteur drug, on prend le carré moyen de 1,73 et on le divise par le carré moyen résiduel de 0,07, ce qui nous donne une statistique F de 26,15. Le calcul correspondant pour la variable therapy serait de diviser 0,47 par 0,07, ce qui donne 7,08 pour la statistique F. Il n’est pas surprenant, bien sûr, que ces valeurs soient les mêmes que celles que Jamovi a rapportées dans le tableau ANOVA ci-dessus.

Le tableau ANOVA contient également le calcul des valeurs p. Encore une fois, il n’y a rien de nouveau ici. Pour chacun de nos deux facteurs, nous essayons de tester l’hypothèse nulle qu’il n’y a pas de relation entre le facteur et la variable résultat (je serai un peu plus précis à ce sujet plus loin). Pour ce faire, nous avons (apparemment) suivi une stratégie similaire à ce que nous avons fait dans le cadre d’ANOVA et nous avons calculé une statistique F pour chacune de ces hypothèses. Pour convertir ces valeurs en p, il suffit de noter que la distribution d’échantillonnage pour la statistique F sous l’hypothèse nulle (que le facteur en question n’est pas pertinent) est une distribution F. Notez également que les deux degrés de liberté sont ceux correspondant au facteur et aux résidus. Pour le facteur drug, il s’agit d’une distribution F avec 2 et 14 degrés de liberté (je reviendrai sur les degrés de liberté plus en détail plus loin). En revanche, pour le facteur therapy, la distribution d’échantillonnage est F avec 1 et 14 degrés de liberté.

À ce stade, j’espère que vous pouvez voir que le tableau ANOVA pour cette analyse factorielle plus complexe devrait être lu de la même façon que le tableau ANOVA pour l’analyse à un facteur plus simple. Bref, il nous dit que l’analyse de variance factorielle pour notre plan 3x2 a permis de trouver un effet significatif du médicament (F(2,14) = 26,15, p< .001) ainsi qu’un effet significatif du traitement (F(1,14) = 7,08, p =.02). Ou, pour utiliser la terminologie techniquement plus correcte, nous dirions qu’il y a deux effets principaux du médicament et de la thérapie. Pour l’instant, il semble probablement un peu redondant de parler d’effets « principaux », mais cela a du sens. Plus tard, nous parlerons de la possibilité « d’interactions » entre les deux facteurs, et nous ferons donc généralement une distinction entre les effets principaux et les effets d’interaction.

14.1.3 Comment la somme des carrés est-elle calculée ?

Dans la section précédente, j’avais deux objectifs. Tout d’abord, pour vous montrer que la méthode Jamovi nécessaire pour faire l’ANOVA factorielle est à peu près la même que celle que nous avons utilisée pour une ANOVA à un facteur. La seule différence est l’ajout d’un deuxième facteur. Deuxièmement, je voulais vous montrer à quoi ressemble le tableau ANOVA dans ce cas, afin que vous puissiez voir d’emblée que la logique et la structure de base de l’ANOVA factorielle sont les mêmes que celles qui sous-tendent l’ANOVA à un facteur. Essayez de vous accrocher à cette idée. C’est tout à fait vrai, dans la mesure où l’ANOVA factorielle est construite plus ou moins de la même manière que le modèle ANOVA à un facteur plus simple. C’est juste que ce sentiment de familiarité commence à s’évaporer une fois que vous commencez à creuser les détails. Traditionnellement, cette sensation réconfortante est remplacée par un besoin irrépressible de maltraiter les auteurs des manuels de statistiques.

Bien, commençons par examiner certains de ces détails. L’explication que j’ai donnée dans la dernière section illustre le fait que les tests d’hypothèse pour les principaux effets (du médicament et de la thérapie dans ce cas) sont des tests F, mais ce qu’il ne fait pas, c’est vous montrer comment la somme des valeurs des carrés (SS) est calculée. Il ne vous dit pas non plus explicitement comment calculer les degrés de liberté (valeurs df) bien que ce soit une chose simple en comparaison. Supposons pour l’instant que nous n’ayons que deux variables prédictrices, le facteur A et le facteur B. Si nous utilisons Y pour nous désigner la variable de résultat, nous utiliserions Yrci pour nous parler du résultat associé au i-ième membre du groupe rc (c.-à-d. niveau/ligne r pour le facteur A et niveau/colonne c pour le facteur B). Ainsi, si l’on utilise \(\bar{Y}\) pour se référer à une moyenne d’échantillon, on peut utiliser la même notation que précédemment pour se référer aux moyennes de groupe, aux moyennes marginales et aux grandes moyennes. C’est-à-dire que \({\bar{Y}}_{rc}\) est la moyenne de l’échantillon associée au r-ième niveau du facteur A et le c-ième niveau du facteur B, \({\bar{Y}}_{r.}\) serait la moyenne marginale du r-ième niveau du facteur A, \({\bar{Y}}_{.c}\) serait la moyenne marginale du c-ième niveau du facteur B, et \({\bar{Y}}_{..}\) est la moyenne générale. En d’autres termes, les moyennes de notre échantillon peuvent être organisées dans le même tableau que les moyennes de population. Pour les données de nos essais cliniques, ce tableau ressemble à ceci :

Et si nous regardons les moyennes de l’échantillon que j’ai montré plus tôt, nous avons \({\bar{Y}}_{11} = 0,30\),\({\bar{Y}}_{12} = 0,60\) etc. Dans notre exemple d’essai clinique, le facteur drug a 3 niveaux et le facteur therapy a 2 niveaux, et ce que nous essayons d’exécuter est une ANOVA factorielle 3 x 2. Cependant, pour être un peu plus général, disons que le Facteur A (le facteur de ligne) a R niveaux et que le Facteur B (le facteur de colonne) a C niveaux , et donc ce que nous faisons ici est une ANOVA factorielle R x C.

Maintenant que nous avons rectifié notre notation, nous pouvons calculer la somme des carrés pour chacun des deux facteurs d’une manière relativement familière. Pour le facteur A, la somme des carrés entre les groupes est calculée en évaluant dans quelle mesure les moyennes marginales (ligne) \({\bar{Y}}_{1.},\ {\bar{Y}}_{2.}\) etc., sont différentes de la moyenne générale\({\bar{Y}}_{\text{..}}\). Nous procédons de la même manière que pour l’analyse de variance à sens unique : nous calculons la somme de la différence au carré entre les valeurs de \({\bar{Y}}_{i.}\) et de \({\bar{Y}}_{..}\). Plus précisément, s’il y a N personnes dans chaque groupe, alors nous calculons ceci

\[ \text{SS}_{A} = (N \times C)\sum_{r = 1}^{R}\left( {\bar{Y}}_{\text{r.}} - {\bar{Y}}_{\text{..}} \right)^{2} \]

Comme pour l’ANOVA à un facteur, la partie la plus intéressante124 de cette formule est \(\left( {\bar{Y}}_{r.} - {\bar{Y}}_{..} \right)^{2}\), qui correspond à l’écart quadratique associé au niveau r. Tout ce que fait cette formule est de calculer cet écart au carré pour tous les niveaux R du facteur, de les additionner, puis de multiplier le résultat par N x C. La raison de cette dernière partie est qu’il y a plusieurs cellules dans notre plan qui ont le niveau r du facteur A. En fait, il y en a C, une pour chaque niveau possible du facteur B ! Ainsi, dans notre exemple, il y a deux cellules différentes dans le plan correspondant au médicament anxifree : une pour les personnes no therapy et une pour le groupe CBT. De plus, à l’intérieur de chacune de ces cellules, il y a N observations. Ainsi, si nous voulons convertir notre valeur SS en une quantité qui détermine la somme des carrés entre les groupes pour « chaque observation », nous devons multiplier par N x C. La formule pour le facteur B est bien sûr la même, mais avec des indices remplacés.

\[ \text{SS}_{B} = (N \times R)\sum_{c = 1}^{C}\left( {\bar{Y}}_{\text{.c}} - {\bar{Y}}_{\text{..}} \right)^{2} \]

Maintenant que nous disposons de ces formules, nous pouvons les comparer à la sortie Jamovi du fichier section précédente. Une fois de plus, un tableur est utile pour ce genre de calculs, alors n’hésitez pas à vous lancer. Vous pouvez également consulter la version que j’ai faite dans Excel dans le fichier clinicaltrial_factorialanova.xls.

Tout d’abord, calculons la somme des carrés associés à l’effet principal de la variable drug. Il y a un total de N = 3 personnes dans chaque groupe et C = 2 types de thérapie différents. Ou, pour le dire autrement, il y a 3 x 2 = 6 personnes qui ont reçu un médicament en particulier. Lorsque nous faisons ces calculs dans un tableur, nous obtenons une valeur de 3,45 pour la somme des carrés associés à l’effet principal de drug. Il n’est donc pas surprenant que ce chiffre soit le même que celui que vous obtenez lorsque vous recherchez la valeur SS pour le facteur drug dans le tableau ANOVA que j’ai présenté plus tôt, à la Figure 14‑3.

Nous pouvons répéter le même type de calcul pour l’effet de la thérapie. Encore une fois il y a N = 3 personnes dans chaque groupe, mais puisqu’il y a R = 3 médicaments différents, cette fois-ci on note qu’il y a 3 X 3 = 9 personnes qui ont reçu la CBT et 9 autres personnes qui ont reçu le placebo. Ainsi, notre calcul dans ce cas nous donne une valeur de 0,47 pour la somme des carrés associés à l’effet principal de therapy. Encore une fois, nous ne sommes pas surpris de constater que nos calculs sont identiques à ceux de l’analyse de variance dans la Figure 14‑3.

C’est donc ainsi que vous calculez les valeurs SS pour les deux effets principaux. Ces valeurs SS sont analogues à la somme des valeurs des carrés entre les groupes que nous avons calculées lors de l’analyse de variance à sens unique au chapitre 13. Cependant, ce n’est plus une bonne idée de les considérer comme des valeurs SS inter groupes, simplement parce que nous avons deux variables de groupement différentes et qu’il est facile de se tromper. Cependant, pour construire un test F, nous devons également calculer la somme des carrés à l’intérieur d’un groupe. Conformément à la terminologie que nous avons utilisée dans le chapitre sur la régression (chapitre 12) et à la terminologie utilisée par Jamovi lors de création du tableau ANOVA, je commencerai par faire référence à la valeur SS à l’intérieur des groupes comme la somme résiduelle des carrés SSR.

La façon la plus simple de comprendre les valeurs résiduelles de la SS dans ce contexte, je pense, est de d’imaginer qu’il s’agit de la variation résiduelle de la variable résultats après avoir pris en compte les différences dans les moyennes marginales (c.-à-d. après avoir enlevé le SSA et le SSB). Ce que je veux dire par là, c’est que nous pouvons commencer par calculer la somme totale des carrés, que j’appellerai SST. La formule est à peu près la même que pour l’ANOVA à un facteur. Nous prenons la différence entre chaque observation Yrci et la grande moyenne \[{\bar{Y}}_{\text{..}}\] .Elevez au carré les différences et additionnez-les toutes.

\[ \text{SS}_{T} = \sum_{r = 1}^{R}{\sum_{c = 1}^{C}{\sum_{i = 1}^{N}{(Y_{\text{rci}} - {\bar{Y}}_{\text{..}})}^{2}}} \]

La « triple sommation » semble ici plus compliquée qu’elle ne l’est. Dans les deux premières sommations, nous additionnons tous les niveaux du facteur A (c.-à-d. toutes les lignes r possibles de notre tableau) et tous les niveaux du facteur B (c.-à-d. toutes les colonnes c possibles). Chaque combinaison rc correspond à un seul groupe et chaque groupe contient N personnes, nous devons donc faire la somme de toutes ces personnes (c’est-à-dire toutes les valeurs i) également. En d’autres termes, tout ce que nous faisons ici est de faire la somme pour toutes les observations de l’ensemble de données (c.-à-d. toutes les combinaisons rci possibles).

A ce stade, nous connaissons la variabilité totale de la variable de résultat SST, et nous savons quelle part de cette variabilité peut être attribuée au facteur A (SSA) et quelle part peut être attribuée au facteur B (SSB). La somme résiduelle des carrés est donc définie comme étant la variabilité en Y qui ne peut être attribuée à aucun de nos deux facteurs. En d’autres termes

\[ \text{SS}_{R} = \text{SS}_{T} - (\text{SS}_{A} + \text{SS}_{B}) \]

Bien sûr, il existe une formule que vous pouvez utiliser pour calculer directement la SS résiduelle, mais je pense qu’il est plus conceptuel de la considérer comme ceci. L’intérêt d’appeler cela un résidu, c’est qu’il s’agit d’une variation résiduelle, et la formule ci-dessus l’indique clairement. Il convient également de noter que, conformément à la terminologie utilisée dans le chapitre sur la régression, il est courant de parler de SSA + SSB comme étant la variance attribuable au « modèle d’ANOVA », noté SSM, on peut ainsi dire que la somme des carrés totale est égale à la somme des carrés du modèle plus la somme des carrés résiduelle. Plus loin dans ce chapitre, nous verrons qu’il ne s’agit pas seulement d’une similitude de surface : ANOVA et régression sont au fond la même chose.

Quoi qu’il en soit, il vaut probablement la peine de prendre un moment pour vérifier que nous pouvons calculer le SSR à l’aide de cette formule et vérifier que nous obtenons la même réponse que celle produite par Jamovi dans son tableau d’ANOVA. Les calculs sont assez simples lorsqu’ils sont effectués dans un tableur (voir le fichier clinicaltrial_factorialanova.xls). Nous pouvons calculer la SS totale à l’aide des formules ci-dessus (pour obtenir une SS totale = 4,85) et ensuite la SS résiduelle (= 0,92). Encore une fois, nous obtenons la même réponse.

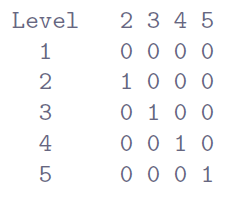

14.1.4 Quels sont nos degrés de liberté ?

Les degrés de liberté sont calculés de la même manière que pour l’ANOVA à un facteur. Pour un facteur donné, les degrés de liberté sont égaux au nombre de niveaux moins 1 (c.-à-d. R - 1 pour la variable de ligne Facteur A et C - 1 pour la variable de colonne Facteur B). Ainsi, pour le facteur drug on obtient df = 2, et pour le facteur thérapeutique on obtient df = 1. Plus loin, lorsque nous discuterons de l’interprétation d’ANOVA comme modèle de régression (voir la section 14.6), je donnerai un énoncé plus clair de la façon dont nous en arrivons à ce chiffre. Mais pour l’instant, nous pouvons utiliser la simple définition des degrés de liberté, à savoir que les degrés de liberté sont égaux au nombre de quantités observées, moins le nombre de contraintes. Ainsi, pour le facteur drug, nous observons 3 moyennes de groupe distinctes, mais celles-ci sont limitées par 1 grande moyenne, et donc les degrés de liberté sont de 2. Pour les résidus, la logique est similaire, mais pas tout à fait la même. Le nombre total d’observations dans notre expérience est de 18. Les contraintes correspondent à 1 grande moyenne, les 2 moyennes de groupes supplémentaires que le facteur drug introduit, et 1 moyenne de groupe supplémentaire pour le facteur therapy, donc notre nombre de degrés de liberté est de 14. Nous avons comme formule N-1-(R-1)-(C-1), qui se simplifie en N-R-C+1.

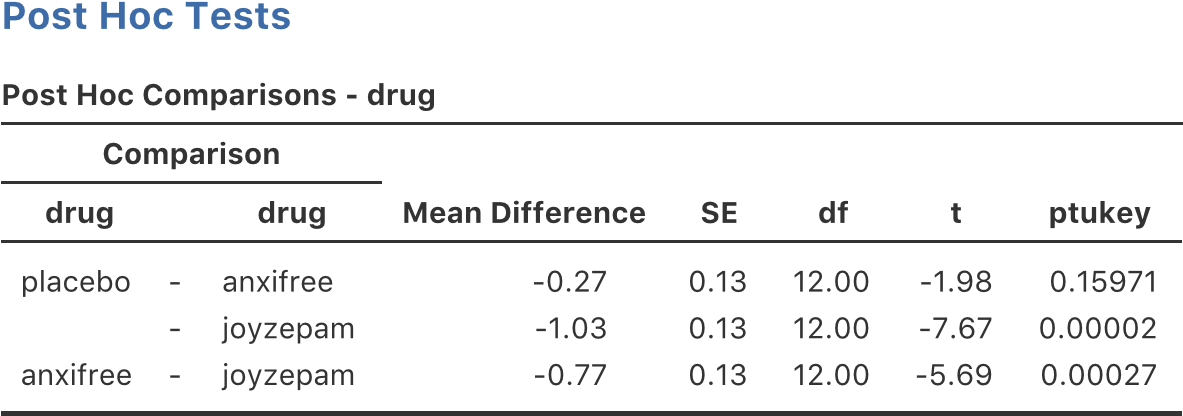

14.1.5 ANOVA factorielle par opposition aux ANOVA à un facteur

Maintenant que nous avons vu comment fonctionne une ANOVA factorielle, il vaut la peine de prendre un moment pour la comparer aux résultats des analyses à un facteur, car cela nous donnera une très bonne idée de la raison pour laquelle l’ANOVA factorielle est intéressante. Au chapitre 13, j’ai effectué une analyse de variance à un facteur pour voir s’il y avait des différences entre les médicaments, et une deuxième analyse de variance à un facteur pour voir s’il y avait des différences entre les traitements. Comme nous l’avons vu à la section 14.1.1, les hypothèses nulles et alternatives testées par les ANOVA à un facteur sont en fait identiques aux hypothèses testées par l’ANOVA factorielle. En regardant encore plus attentivement les tableaux ANOVA, on constate que la somme des carrés associés aux facteurs est identique dans les deux analyses (3,45 pour drug et 0,92 pour therapy), tout comme les degrés de liberté (2 pour drug, 1 pour therapy). Mais ils ne donnent pas les mêmes réponses ! Plus particulièrement, lorsque nous avons utilisé l’analyse de variance à un facteur pour therapy à la section 13.10, nous n’avons pas trouvé d’effet significatif (la valeur p était de .21). Cependant, quand on regarde l’effet principal de therapy dans le contexte de l’ANOVA bifactorielle, on obtient un effet significatif (p=.019). Les deux analyses ne sont manifestement pas les mêmes.

Pourquoi cela se produit-il ? Pour répondre, il faut comprendre comment les résidus sont calculés. Rappelons que l’idée derrière un test F est de comparer la variabilité qui peut être attribuée à un facteur particulier avec la variabilité qui ne peut être prise en compte (les résidus). Si vous utilisez une ANOVA à un facteur pour therapy, et que vous ignorez donc l’effet de drug, l’ANOVA comptabilisera toute la variabilité induite par drug dans les résidus ! Cela a pour effet de d’introduire plus de bruit dans les données qu’il n’y en a en réalité, et l’effet de therapy qui s’avère à juste titre significatif dans l’ANOVA bifactorielle devient maintenant non significatif. Si nous ignorons quelque chose qui compte vraiment (p. ex., le facteur drug) lorsque nous essayons d’évaluer la contribution d’autre chose (p. ex., le facteur therapy), notre analyse sera faussée. Bien sûr, il est tout à fait normal d’ignorer les variables qui ne sont pas vraiment pertinentes pour le phénomène d’intérêt. Si nous avions enregistré la couleur des murs et que cela se soit avéré être un facteur non important dans une analyse de variance à trois facteurs, il serait tout à fait acceptable de ne pas en tenir compte et de signaler simplement l’analyse de variance à deux facteurs plus simple qui ne comprend pas ce facteur non pertinent. Ce que vous ne devriez pas faire, c’est laisser tomber les variables qui font vraiment une différence !

14.1.6 Quels types de résultats cette analyse saisit-elle ?

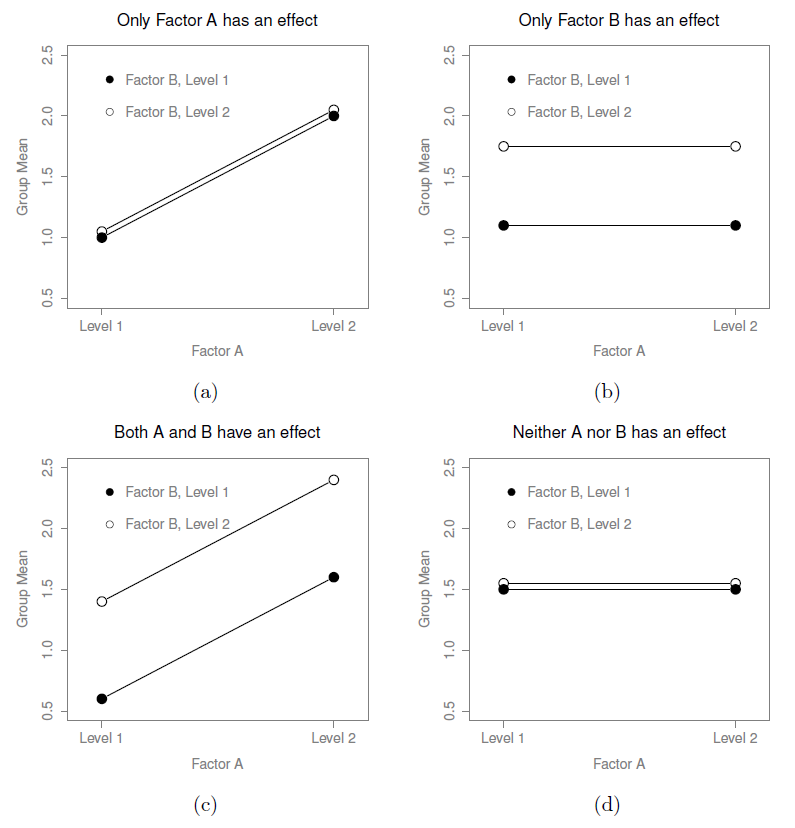

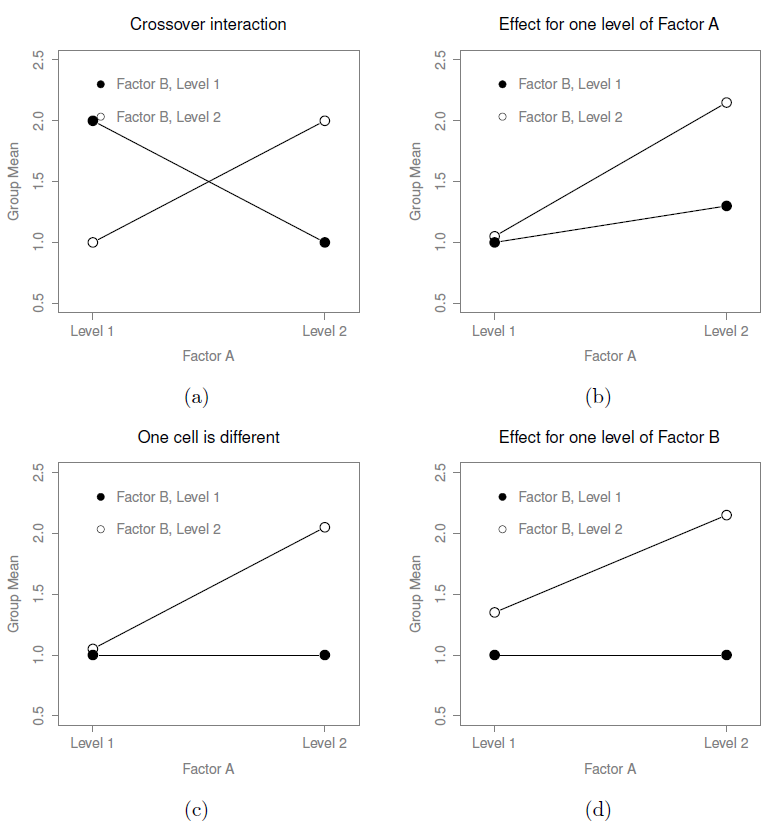

Le modèle ANOVA dont nous avons parlé jusqu’à présent couvre une gamme de modèles différents que nous pourrions observer dans nos données. Par exemple, dans une conception ANOVA bifactorielle, il y a quatre possibilités : (a) seul le facteur A compte, (b) seul le facteur B compte, (c) à la fois le facteur A et le facteur B compte, et (d) ni A ni B ne comptent. Un exemple de chacune de ces quatre possibilités est présenté à la Figure 14‑4.

14.2 ANOVA Factorielle 2 : conceptions équilibrées, interactions permises

Les quatre modèles de données présentés à la Figure 14‑4 sont tous très réalistes. Il existe un grand nombre d’ensembles de données qui produisent exactement ces tendances. Cependant, ils ne représentent pas toute l’histoire et le modèle ANOVA dont nous avons parlé jusqu’à présent ne suffit pas à rendre pleinement compte d’un tableau des moyennes de groupe. Pourquoi pas ? Pourquoi pas ? Eh bien, jusqu’à présent, nous avons la possibilité de parler de l’idée que les drogues peuvent influencer l’humeur, et la thérapie peut influencer l’humeur, mais pas la possibilité d’une interaction entre les deux. On dit qu’une interaction entre A et B se produit lorsque l’effet du facteur A est différent, selon le niveau du facteur B dont il est question. Plusieurs exemples d’un effet d’interaction avec le contexte d’une ANOVA 2ˆ2 sont présentés à la Figure 14‑5. Pour donner un exemple plus concret, supposons que le fonctionnement d’Anxifree et Joyzepam est régi par des mécanismes physiologiques très différents. L’une des conséquences de cette situation est que bien que Joyzepam ait plus ou moins le même effet sur l’humeur, que l’on soit en thérapie ou non, Anxifree est en fait beaucoup plus efficace lorsqu’il est administré conjointement avec la TCC.

Figure 14‑4 : Les quatre résultats différents d’une 2 x 2 ANOVA en l’absence d’interaction. Dans la figure (a), nous voyons un effet principal du facteur A et aucun effet du facteur B. La figure (b) montre un effet principal du facteur B mais aucun effet du facteur A. La figure (c) montre des effets principaux du facteur A et du facteur B. Enfin, la figure (d) ne montre aucun effet des deux facteurs.

Figure 14‑5 : Des interactions qualitativement différentes pour une 2 x 2 ANOVA

L’analyse de variance que nous avons élaborée dans la section précédente ne tient pas compte de cette idée. Pour se faire une idée de la réalité d’une interaction ici, il est utile de tracer les différentes moyennes de groupe. Dans le Jamovi, cela se fait via l’option « Descriptive Plots » de l’ANOVA - il suffit de déplacer le facteur drug dans la case « Horizontal axis », et de déplacer therapy dans la case « Separate Lines ». Ceci devrait ressembler à la Figure 14‑6. Notre principale préoccupation concerne le fait que les deux lignes ne sont pas parallèles. L’effet de la CBT (différence entre la ligne pleine et la ligne pointillée) lorsque le médicament est le Joyzepam (côté droit) semble être près de zéro, encore plus petit que l’effet de la CBT lorsqu’un placebo est utilisé (côté gauche). Cependant, lorsqu’Anxifree est administré, l’effet de la CBT est plus important que celui du placebo (milieu). Cet effet est-il réel ou s’agit-il d’une variation aléatoire due au hasard ? Notre analyse de variance originale ne peut pas répondre à cette question, car nous ne tenons pas compte de l’idée que les interactions existent même ! Dans cette section, nous allons régler ce problème.

Figure 14‑6 : copie d’écran Jamovi montrant comment générer un diagramme d’interaction descriptif dans ANOVA en utilisant les données des essais cliniques

14.2.1 Qu’est-ce qu’un effet d’interaction ?

L’idée clé que nous allons introduire dans cette section est celle d’un effet d’interaction. Dans le modèle ANOVA que nous avons examiné jusqu’à présent, il n’y a que deux facteurs en cause dans notre modèle (c.-à-d. drug et la therapy). Mais lorsque nous ajoutons une interaction, nous ajoutons une nouvelle composante au modèle : la combinaison de drug et de therapy. Intuitivement, l’idée derrière un effet d’interaction est assez simple. Cela signifie simplement que l’effet du facteur A est différent selon le niveau du facteur B dont nous parlons. Mais qu’est-ce que cela signifie réellement en termes de données ? Le graphique de la Figure 14‑5 illustre plusieurs modèles qui, bien que très différents les uns des autres, seraient tous considérés comme un effet d’interaction. Il n’est donc pas tout à fait simple de traduire cette idée qualitative en une notion mathématique avec laquelle un statisticien peut travailler.

Par conséquent, la façon dont l’idée d’un effet d’interaction est formalisée en termes d’hypothèses nulles et alternatives est un peu difficile, et je suppose que beaucoup de lecteurs de ce livre ne seront probablement pas très intéressés. Néanmoins, je vais essayer de donner l’idée de base ici.

Pour commencer, nous devons être un peu plus explicites sur nos principaux effets. Considérons l’effet principal du facteur A (drug dans notre exemple courant). Nous avons initialement formulé cette hypothèse en fonction de l’hypothèse nulle que les deux moyennes marginales \(\mu_{r.}\) sont égales l’une à l’autre. Évidemment, si toutes ces valeurs sont égales les unes aux autres, alors elles doivent aussi être égales à la grande moyenne \(\mu_{..}\) On peut donc définir l’effet du facteur A au niveau r comme étant égal à la différence entre la moyenne marginale \(\mu_{r}\) et la moyenne générale \(\mu_{..}\). Signalons cet effet par \(\alpha_{r}\), et notons que

\[ \alpha_{r} = \mu_{r.} - \mu_{..} \]

Maintenant, par définition, la somme de toutes les valeurs de \(\alpha_{r}\) doivent être égales à zéro, pour la même raison que la moyenne des moyennes marginales \(\mu_{r.}\) doit être égale à la grande moyenne \(\mu_{..}\). De même, nous pouvons définir l’effet du facteur B au niveau i comme étant la différence entre la moyenne marginale de la colonne \(\mu_{.c}\) et la moyenne générale \(\mu_{..}\)

\[ \beta_{c} = \mu_{.c} - \mu_{..} \]

et une fois de plus, la somme de ces valeurs de \(\beta_{c}\) doit être égale à zéro. Les statisticiens aiment parfois parler des principaux effets avec ces valeurs \(\alpha_{r}\) et \(\beta_{c}\) car cela leur permet d’être précis sur ce que signifie il n’y a aucun effet d’interaction. S’il n’y a aucune interaction, alors ces valeurs \(\alpha_{r}\) et \(\beta_{c}\) décrivent parfaitement le la moyenne de groupe \(\mu_{rc}\). Plus précisément, cela signifie que

\[ u_{rc} = u_{..} + \alpha_{r} + \beta_{c} \]

En d’autres termes, il n’y a rien de particulier pour à propos des moyennes de groupe que vous ne pourriez pas prédire parfaitement en connaissant tous les moyennes marginales. Et c’est notre hypothèse nulle, justement. L’hypothèse alternative est que

\[ u_{rc} \neq u_{..} + \alpha_{r} + \beta_{c} \]

pour au moins un groupe rc dans notre tableau. Cependant, les statisticiens aiment souvent écrire cela un peu différemment. Ils définiront habituellement l’interaction spécifique associée au groupe rc comme étant un certain nombre, maladroitement appelé \(\left( \alpha\beta \right)_{rc}\), puis ils diront que l’hypothèse alternative est que

\[ u_{rc} = u_{..} + \alpha_{r} + \beta_{c} + \left( \alpha\beta \right)_{rc} \]

où \(\left( \alpha\beta \right)_{rc}\) est différent de zéro pour au moins un groupe. Cette notation est plutôt moche à regarder, mais elle est pratique comme nous le verrons dans la prochaine section lorsque nous discuterons de la façon de calculer la somme des carrés.

14.2.2 Calcul des sommes de carrés pour l’interaction

Comment calculer la somme des carrés des termes d’interaction, SSA:B ? Eh bien, tout d’abord, il est utile de noter comment la section précédente a défini l’effet d’interaction en fonction de la mesure de la différence entre les moyennes réelles du groupe et ce à quoi on pourrait s’attendre en regardant simplement les moyennes marginales. Bien sûr, toutes ces formules font référence à des paramètres de population plutôt qu’à des statistiques d’échantillonnage, de sorte que nous ne savons pas vraiment ce qu’elles sont. Cependant, nous pouvons les estimer en utilisant des moyennes d’échantillonnage au lieu des moyennes de population. Ainsi, pour le facteur A, une bonne façon d’estimer l’effet principal au niveau r est la différence entre la moyenne marginale \({\bar{Y}}_{rc}\) de l’échantillon et la moyenne générale \({\bar{Y}}_{..}\) . En d’autres termes, nous utiliserions ceci comme notre estimation de l’effet

\[ {\hat{\alpha}}_{r} = {\bar{Y}}_{r.} - {\bar{Y}}_{..} \]

De la même façon, notre estimation de l’effet principal du facteur B au niveau c peut être définie comme suit

\[ {\hat{\beta}}_{c} = {\bar{Y}}_{.c} - {\bar{Y}}_{..} \]

Maintenant, si vous revenez aux formules que j’ai utilisées pour décrire les valeurs SS pour les deux effets principaux, vous remarquerez que ces termes d’effets sont exactement les quantités que nous avons élevées au carré et additionnées ! Alors, quel est l’analogie de ceci pour les termes d’interaction ? La réponse à cette question peut être trouvée en réarrangeant d’abord la formule de ma moyenne \(\mu_{rc}\) pour le groupe sous l’hypothèse alternative, donc

\[\begin{aligned} \left( \alpha\beta \right)_{rc} &= \mu_{rc} - \mu_{..} - \alpha_{.r} - \beta_{c}\\ &= \mu_{rc} - \mu_{..} - \left( \mu_{r.} - \mu_{..} \right) - \left( \mu_{.c} - \mu_{..} \right)\\ &= \mu_{rc} - \mu_{r.} - \mu_{.c} + \mu_{..} \end{aligned} \]

Donc, encore une fois, si nous substituons nos statistiques d’échantillon à la moyenne de la population, nous obtenons ce qui suit comme estimation de l’effet d’interaction pour le groupe rc,

\[ \left( \hat{\alpha\beta} \right)_{\text{rc}} = {\bar{Y}}_{\text{rc}} - {\bar{Y}}_{\text{r.}} - {\bar{Y}}_{\text{.c}} + {\bar{Y}}_{\text{..}} \]

Il ne nous reste plus qu’à additionner toutes ces estimations pour tous les niveaux R du facteur A et tous les niveaux C du facteur B, et nous obtenons la formule suivante pour la somme des carrés associés à l’interaction dans son ensemble

\[ \text{SS}_{A:B} = N\sum_{r = 1}^{R}{\sum_{c = 1}^{C}\left( {\bar{Y}}_{\text{rc}} - {\bar{Y}}_{\text{r.}} - {\bar{Y}}_{\text{.c}} + {\bar{Y}}_{\text{..}} \right)^{2}} \]

où nous multiplions par N parce qu’il y a N observations dans chacun des groupes, et nous voulons que nos valeurs SS reflètent la variation entre les observations expliquées par l’interaction, et non la variation entre groupes.

Maintenant que nous avons une formule pour calculer SSA:B, il est important de reconnaître que le terme d’interaction fait partie du modèle (bien sûr), donc la somme totale des carrés associés au modèle, SSM, est maintenant égale à la somme des trois valeurs SS pertinentes, SSA + SSB + SSA:B. La somme résiduelle des carrés SSR est toujours définie comme la variation restante, à savoir SST-SSM, mais maintenant que nous avons le terme d’interaction cela devient

\[ \text{SS}_{R} = \text{SS}_{T} - \left( \text{SS}_{A} + \text{SS}_{B} + \text{SS}_{A:B} \right) \]

Par conséquent, la somme résiduelle des carrés SSR sera plus petite que dans notre ANOVA originale qui ne comprenait pas les interactions

14.2.3 Degrés de liberté pour l’interaction

Le calcul des degrés de liberté pour l’interaction est, une fois de plus, légèrement plus délicat que le calcul correspondant pour les effets principaux. Pour commencer, pensons au modèle ANOVA dans son ensemble. Une fois que nous incluons les effets d’interaction dans le modèle, nous permettons à chaque groupe d’avoir une moyenne unique, \(\mu_{rc}\). Pour une ANOVA factorielle R x C, cela signifie qu’il y a R x C quantités d’intérêt dans le modèle et qu’il n’y a qu’une seule contrainte : toutes les moyennes du groupe doivent être égales à la moyenne générale. Ainsi, le modèle dans son ensemble doit avoir (R x C)-1 degrés de liberté. Mais l’effet principal du facteur A a R-1 degrés de liberté, et l’effet principal du facteur B a C-1 degrés de liberté. Cela signifie que les degrés de liberté associés à l’interaction sont les suivants

\[\begin{aligned} df_{A:B} &= \left( R \times C - 1 \right) - \left( R - 1 \right) - \left( C - 1 \right)\\ &= RC - C + 1\\ &= (R - C)(C - 1) \end{aligned} \]

qui n’est que le produit des degrés de liberté associés au facteur de ligne et au facteur de colonne.

Qu’en est-il des degrés de liberté résiduels ? Parce que nous avons ajouté des termes d’interaction qui absorbent certains degrés de liberté, il reste moins de degrés de liberté résiduels. Plus précisément, notez que si le modèle avec interaction a un total de (R x C)-1, et qu’il y a N observations dans votre ensemble de données qui sont contraintes de satisfaire 1 grande moyenne, vos degrés de liberté résiduels deviennent maintenant N-(R x C)-1+1, ou seulement N-(R x C).

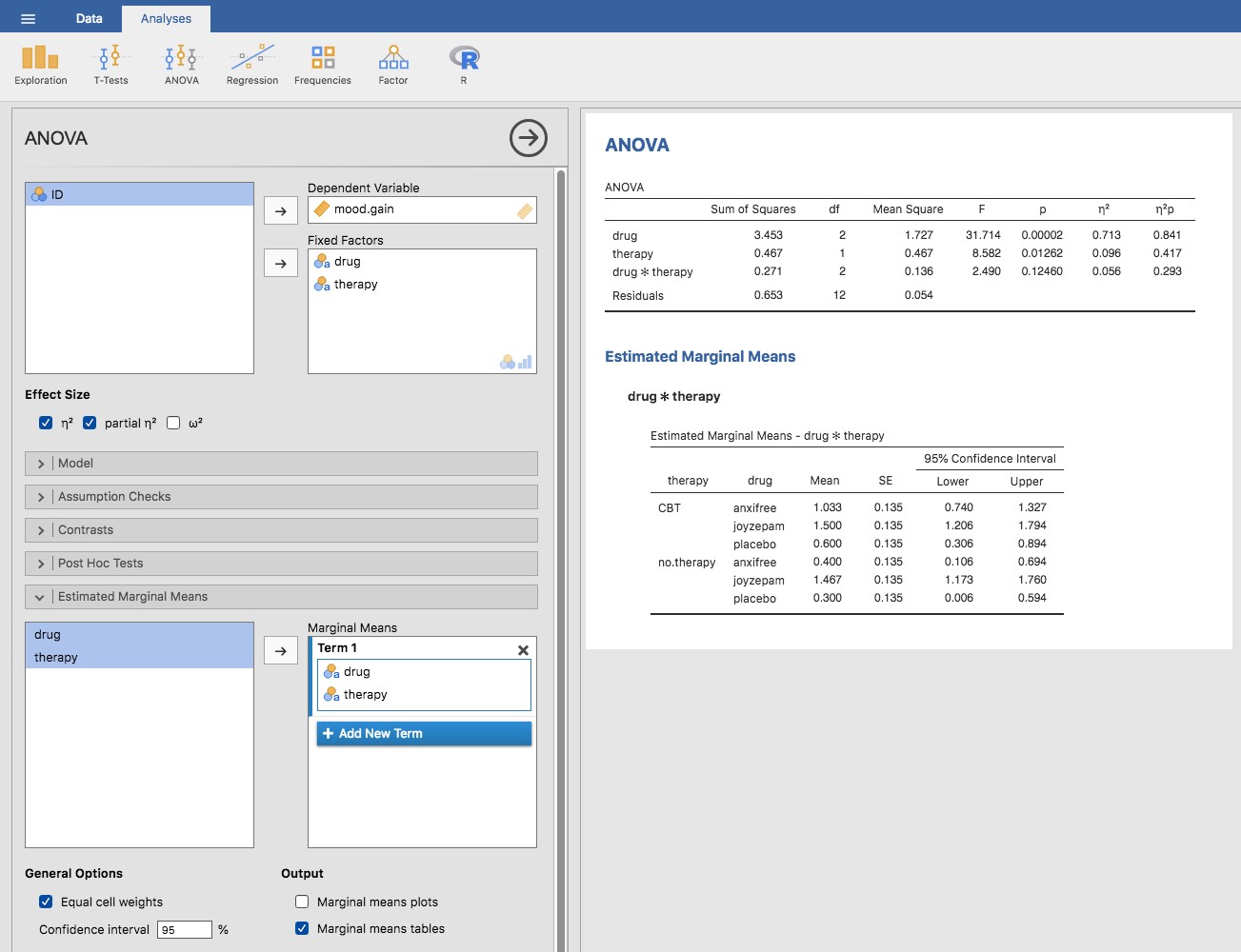

14.2.4 Exécuter l’ANOVA dans Jamovi

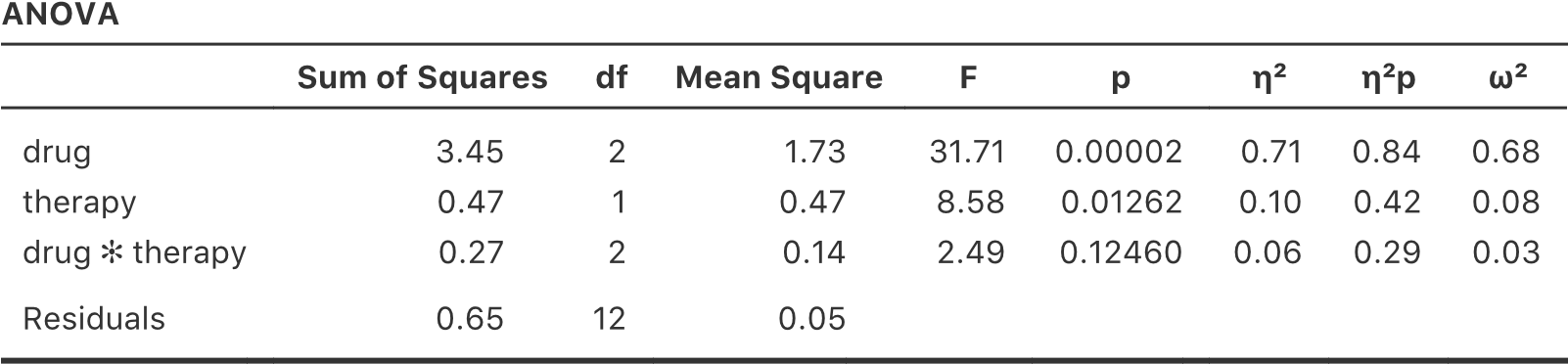

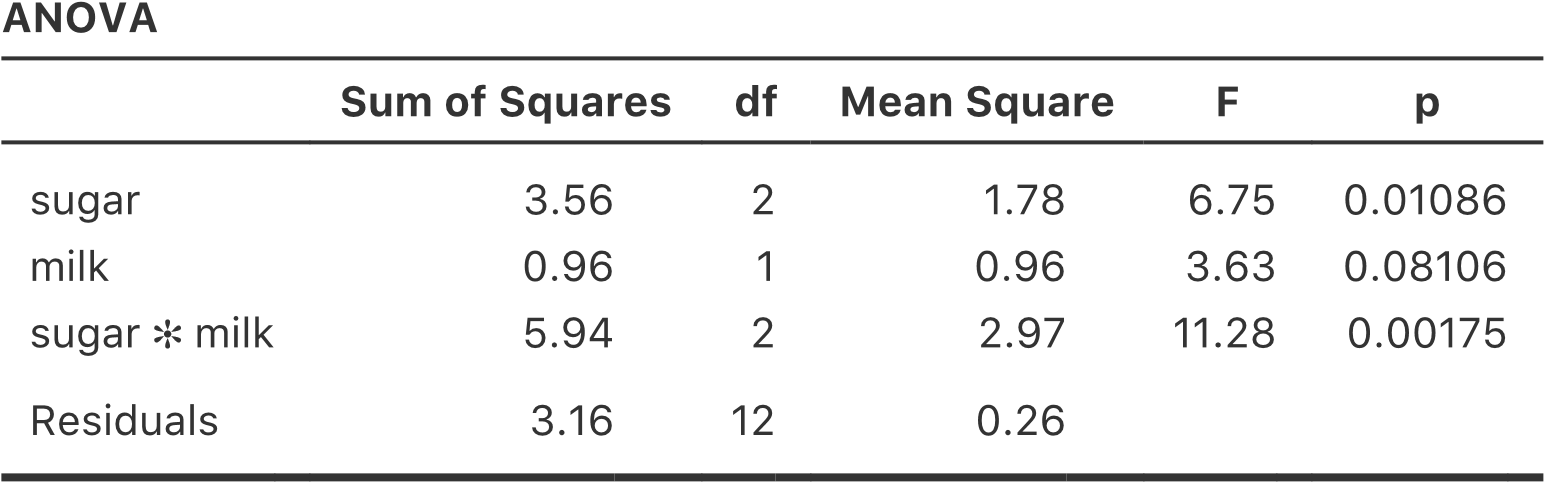

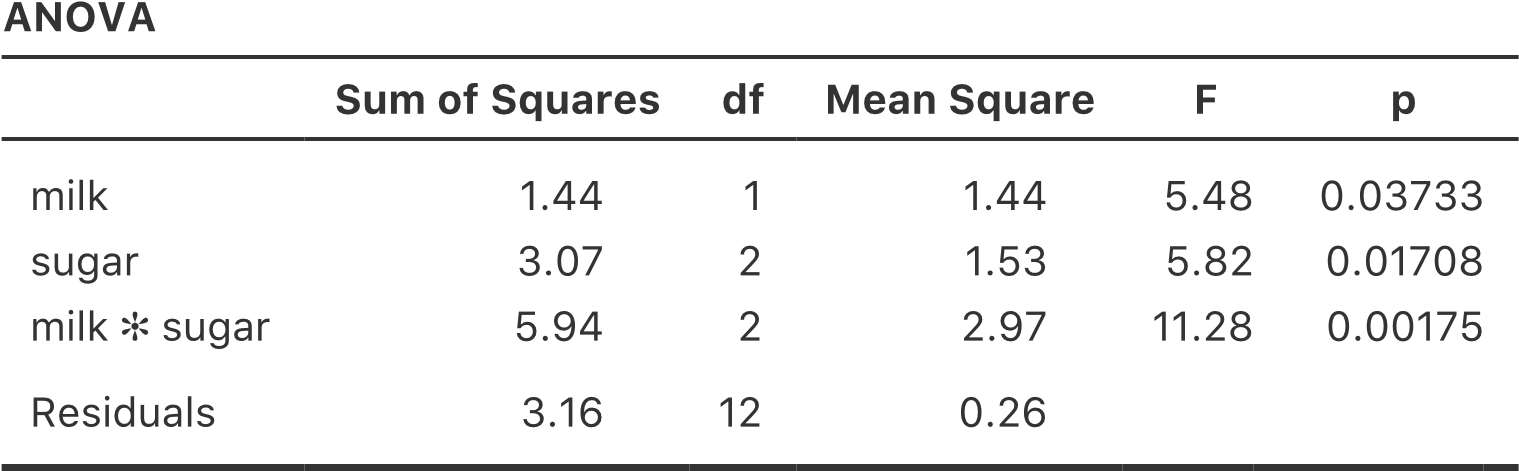

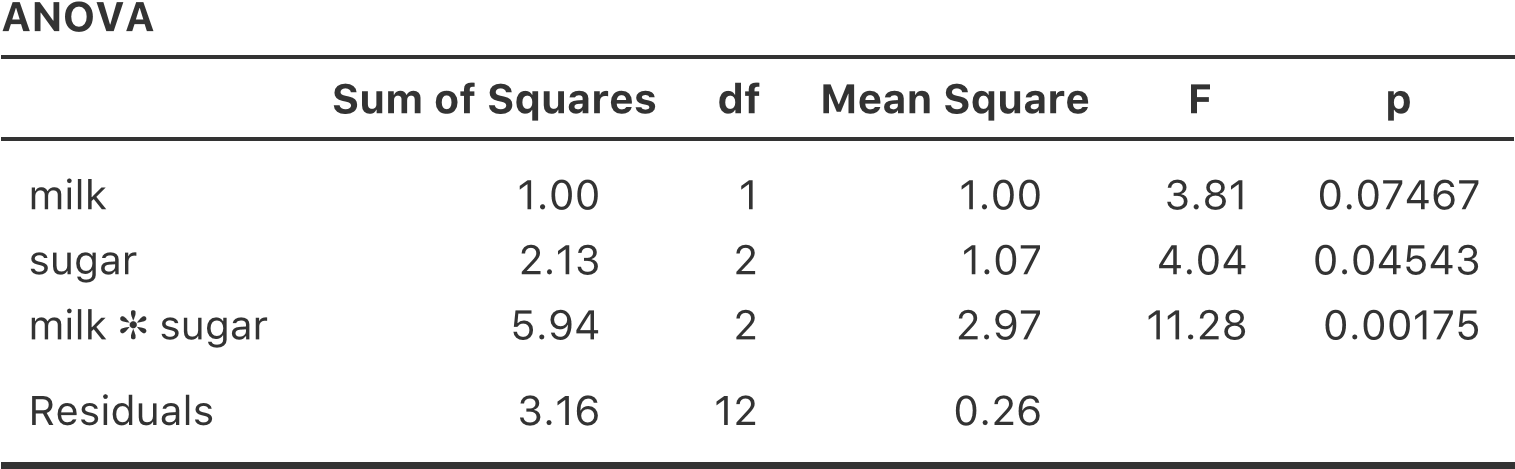

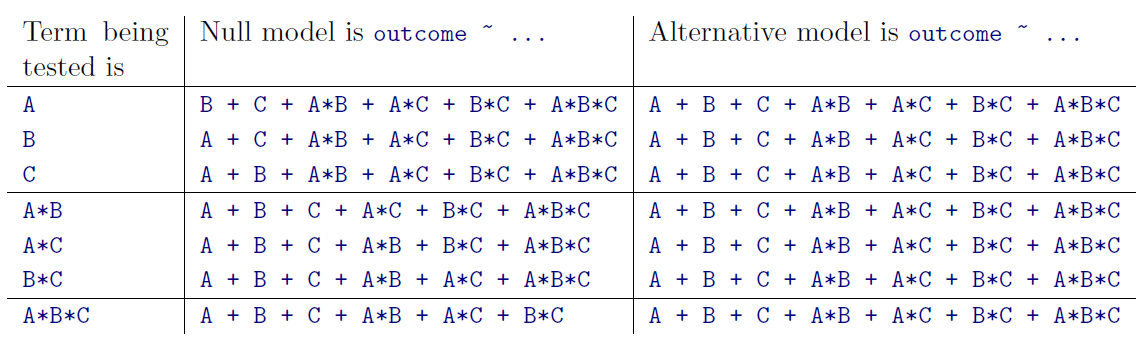

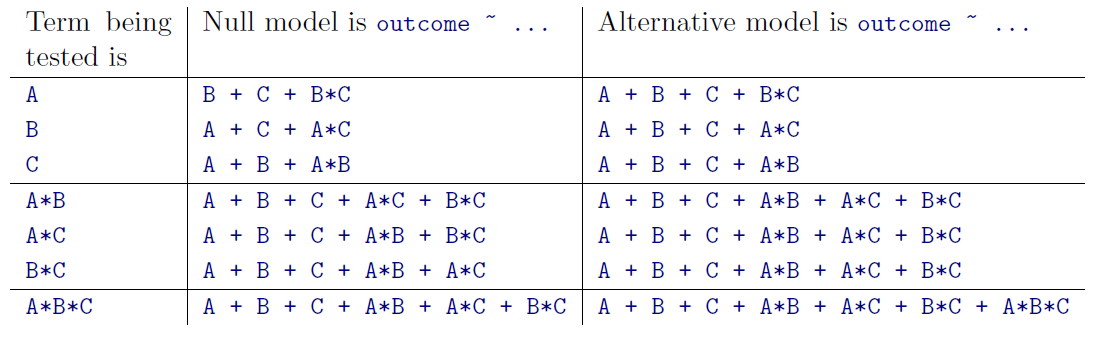

L’ajout de termes d’interaction au modèle ANOVA dans Jamovi est simple. En fait, c’est plus que simple parce que c’est l’option par défaut pour ANOVA. Cela signifie que lorsque vous spécifiez une ANOVA avec deux facteurs, par exemple drug et therapy, la composante d’interaction - drug*therapy - est automatiquement ajoutée au modèle125. Lorsque nous exécutons l’analyse de variance avec le terme d’interaction inclus, nous obtenons les résultats présentés à la Figure 14‑7.

Il s’avère que, bien que nous ayons un effet principal significatif du médicament (F(2,12) = 31,7, p<.001) et le type de thérapie (F(1,12) = 8,6, p=.013), il n’y a aucune interaction significative entre les deux (F(2,12) = 2,5, p=0.125).

Figure 14‑7 : Résultats pour le modèle factoriel complet, y compris la composante d’interaction drug*therapy

14.2.5 Interprétation des résultats

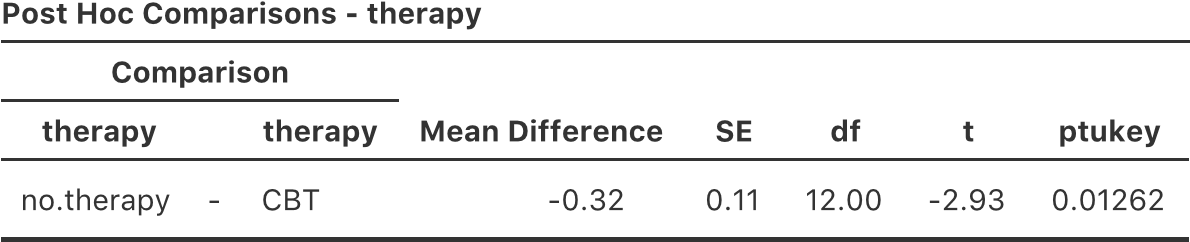

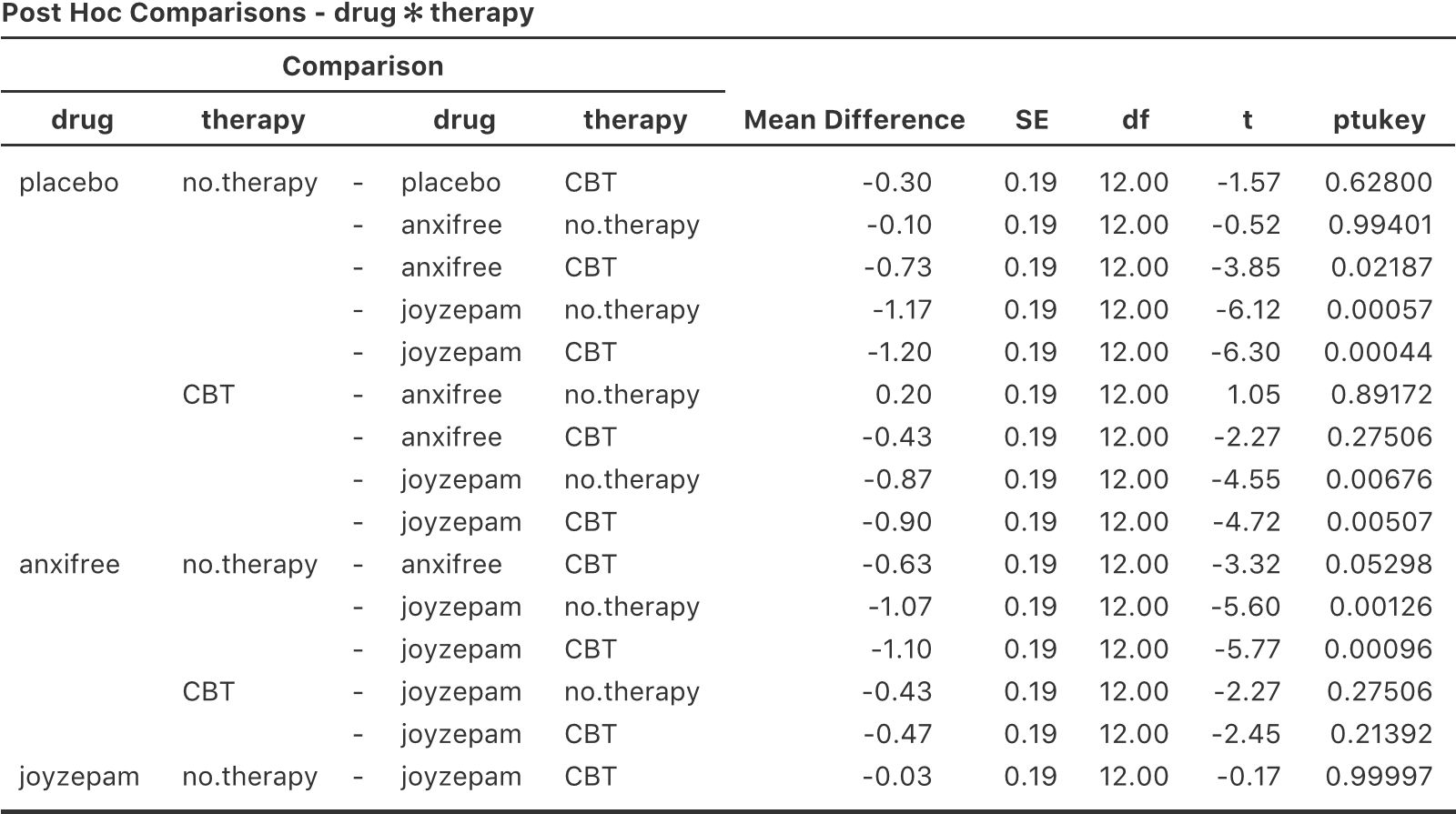

Il y a quelques éléments très importants à prendre en considération lors de l’interprétation des résultats de l’analyse de variance factorielle. Tout d’abord, il y a le même problème que nous avions avec l’analyse de variance à un facteur, si vous obtenez un effet principal important d’un facteur (disons) drug, cela ne vous dit rien sur les différences entre médicaments. Pour le savoir, vous devez exécuter des analyses supplémentaires. Nous parlerons de certaines analyses que vous pouvez exécuter dans les sections 14.7 et 14.8. Il en va de même pour les effets d’interaction. Savoir qu’il y a une interaction importante ne vous dit rien sur le type d’interaction qui existe. Encore une fois, vous devrez effectuer des analyses supplémentaires.

Deuxièmement, il y a un problème d’interprétation très particulier qui se pose lorsque vous obtenez un effet d’interaction significatif mais aucun effet principal correspondant. Cela arrive parfois. Par exemple, dans l’interaction croisée illustrée à la Figure 14‑5a, c’est exactement ce que vous trouverez. Dans ce cas, ni l’un ni l’autre des principaux effets ne serait significatif, mais l’effet d’interaction le serait. C’est une situation difficile à interpréter, et les gens sont souvent un peu confus. Le conseil général que les statisticiens aiment donner dans cette situation est que vous ne devriez pas accorder beaucoup d’attention aux effets principaux quand une interaction est présente. La raison en est que, bien que les tests des effets principaux soient parfaitement valables d’un point de vue mathématique, lorsqu’il y a un effet d’interaction significatif, les effets principaux testent rarement des hypothèses intéressantes. Rappelons, à la section 14.1.1, que l’hypothèse nulle pour un effet principal est que les moyennes marginales sont égales les unes aux autres et qu’une moyenne marginale est formée en faisant la moyenne de plusieurs groupes différents. Mais si vous avez un effet d’interaction significatif, vous savez que les groupes qui composent la moyenne marginale ne sont pas homogènes, alors le motif de l’intérêt pour ces moyennes marginales n’est pas vraiment évident.

Je tenais à le préciser. Encore une fois, restons-en à un exemple clinique. Supposons que nous ayons un plan 2x2 comparant deux thérapies différentes pour les phobies (p. ex. désensibilisation systématique vs exposition in vivo) et deux médicaments anti-anxiété différents (p. ex. Anxifree vs Joyzepam). Supposons maintenant que ce que nous avons découvert, c’est qu’Anxifree n’avait aucun effet lorsque la thérapie est la désensibilisation, et que Joyzepam n’avait aucun effet avec l’exposition in vivo. Mais les deux ont été assez efficaces pour l’autre thérapie. Il s’agit d’une interaction croisée classique, et ce que nous constatons en exécutant l’analyse de variance, c’est qu’il n’y a pas d’effet principal du médicament, mais une interaction significative. Maintenant, qu’est-ce que cela signifie de dire qu’il n’y a pas d’effet principal ? Eh bien, cela signifie que si nous faisons la moyenne sur les deux traitements psychologiques, alors l’effet moyen d’Anxifree et de Joyzepam est le même. Mais qui cela intéresse-t-il ? Lorsqu’on traite quelqu’un pour des phobies, il n’est jamais possible de traiter une personne en utilisant une « moyenne » d’exposition et de désensibilisation. Ça n’a pas beaucoup de sens. Soit vous avez l’un, soit l’autre. Pour un traitement, un médicament est efficace, et pour l’autre, c’est l’autre médicament qui est efficace. Ce qui importe, c’est l’interaction et l’effet principal n’a pas d’importance.

Ce genre de choses arrive souvent. Les principaux effets sont des tests de moyennes marginales, et lorsqu’une interaction est présente, nous trouvons souvent les moyennes marginales sans grand intérêt parce qu’elles impliquent de faire la moyenne des choses dont l’interaction nous dit de ne pas en faire la moyenne ! Bien sûr, il n’est pas toujours vrai qu’un effet principal n’a pas de sens lorsqu’une interaction est présente. Souvent, on peut obtenir un grand effet principal et une très petite interaction, auquel cas on peut encore dire des choses comme « le médicament A est généralement plus efficace que le médicament B » (parce qu’il y avait un grand effet du médicament), mais il faudrait le modifier un peu en ajoutant que « la différence d’efficacité était différente en fonction des différents traitements psychologiques ». Quoi qu’il en soit, le point principal ici est que chaque fois que vous obtenez une interaction significative, vous devriez vous arrêter et réfléchir à ce que l’effet principal signifie réellement dans ce contexte. Ne supposez pas automatiquement que l’effet principal est intéressant.

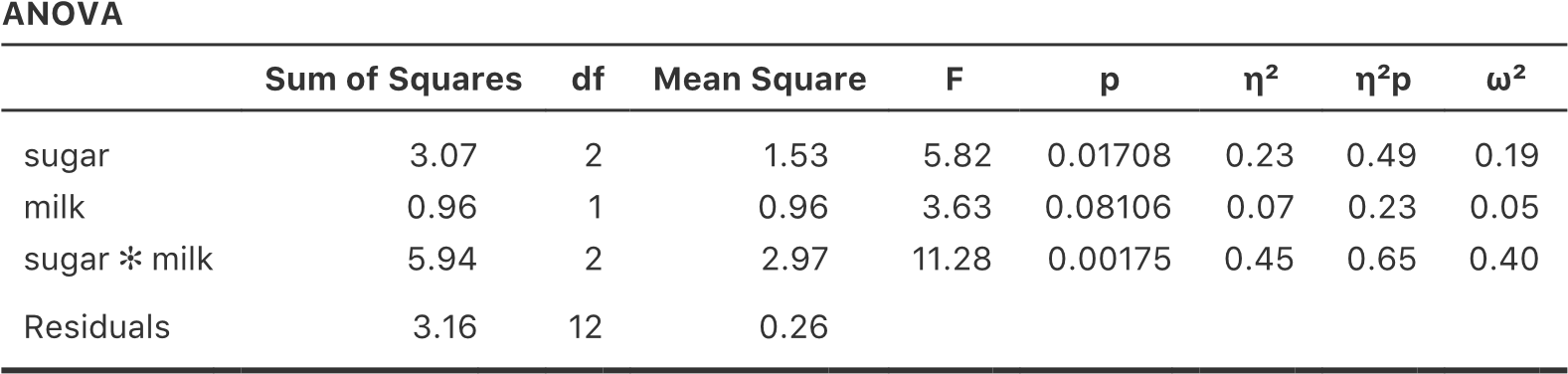

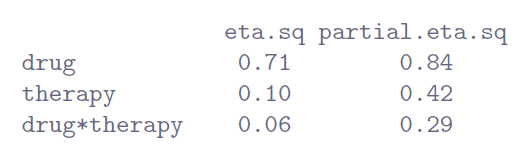

14.3 Taille de l’effet

Le calcul de la valeur de l’effet d’une ANOVA factorielle est assez semblable à celui d’une ANOVA à un facteur (voir section 13.4). Plus précisément, nous pouvons utiliser \(\eta^{2}\) (eta-carré) comme un moyen simple de mesurer la taille de l’effet global pour un terme donné. Comme précédemment, \(\eta^{2}\) est défini en divisant la somme des carrés associés à ce terme par la somme totale des carrés. Par exemple, pour déterminer l’ampleur de l’effet principal du facteur A, nous utiliserions la formule suivante :

\[ \eta^{2} = \frac{\text{SS}_{A}}{\text{SS}_{T}} \]

Comme précédemment, ceci peut être interprété de la même manière que R2 en régression.126 Il vous indique la proportion de variance de la variable résultat qui peut être expliquée par l’effet principal du facteur A. Il s’agit donc d’un nombre qui varie de 0 (aucun effet du tout) à 1 (qui explique toute la variabilité du résultat). De plus, la somme des valeurs de \(\eta^{2}\) pour tous les termes du modèle est égale au R2 total pour le modèle d’ANOVA. Si, par exemple, le modèle ANOVA est parfaitement adapté (c’est-à-dire qu’il n’y a aucune variabilité à l’intérieur des groupes !), la somme des valeurs \(\eta^{2}\) sera égale à 1. Bien sûr, cela arrive rarement, voire jamais, dans la vraie vie.

Cependant, lorsqu’on effectue une analyse de variance factorielle, il existe une deuxième mesure de la taille de l’effet que les gens aiment signaler, connue sous le nom de \(\eta^{2}\) partiel. L’idée qui sous-tend le \(\eta^{2}\) partiel (noté parfois \(_{p}^{}\eta^{2}\) ou \(\eta_{p}^{2}\)) est que, lorsqu’on mesure l’ampleur de l’effet pour un terme particulier (disons, l’effet principal du facteur A), on veut délibérément ignorer les autres effets du modèle (p. ex., l’effet principal du facteur B). C’est-à-dire, vous souhaiteriez faire semblant que l’effet de tous ces autres termes est nul afin de calculer ce que la valeur de \(\eta^{2}\) aurait été. C’est en fait assez facile à calculer. Tout ce que vous avez à faire est d’enlever la somme des carrés associés aux autres termes du dénominateur. En d’autres termes, si vous voulez l’effet principal du Facteur A sur \(\eta^{2}\), le dénominateur est juste la somme des carrés du Facteur A et des résidus.

\[ \text{partial }\eta_{A}^{2} = \frac{\text{SS}_{A}}{\text{SS}_{A} + \text{SS}_{R}} \]

Cela vous donnera toujours un nombre plus grand que \(\eta^{2}\), ce que le cynique que je suis soupçonne d’expliquer la popularité de \(\eta^{2}\) partiel. Et encore une fois, vous obtenez un nombre entre 0 et 1, où 0 représente aucun effet. Cependant, il est un peu plus difficile d’interpréter ce que signifie une grande valeur partielle de \(\eta^{2}\). En particulier, vous ne pouvez pas comparer les valeurs partielles de \(\eta^{2}\) d’un terme à l’autre ! Supposons, par exemple, qu’il n’y ait aucune variabilité à l’intérieur des groupes, dans ce cas, SSR = 0. Cela signifie que chaque terme a une valeur partielle \(\eta^{2}\) de 1. Mais cela ne signifie pas que tous les termes dans votre modèle sont également importants, ou même qu’ils sont aussi grands. Tout ce que cela signifie, c’est que tous les termes de votre modèle ont des valeurs d’effet qui sont importantes par rapport à la variation résiduelle. Elle n’est pas comparable d’un terme à l’autre.

Pour voir ce que j’entends par là, il est utile de voir un exemple concret. Examinons d’abord la taille de l’effet de l’analyse de variance originale sans le terme d’interaction, à la Figure 14‑3 :

| Eta.sq | Partial.eta.sq | |

| drug | 0,71 | 0,79 |

| therapy | 0,10 | 0,34 |

En regardant d’abord les valeurs de \(\eta^{2}\), on constate que drug représente 71 % de la variance (c.-à-d. \(\eta^{2}=0,71\)) pour la variable mood.gain, alors que le facteur therapy ne représente que 10 %. Cela laisse un total de 19 % de la variation non prise en compte (c.-à-d. que les résidus constituent 19 % de la variation du résultat). Dans l’ensemble, cela implique que nous avons un très grand effet de127 drug et un effet modeste de therapy.

Regardons maintenant les valeurs partielles de \(\eta^{2}\), illustrées à la Figure 14‑3. Parce que l’effet de therapy n’est pas si important, le contrôle de l’effet ne fait pas beaucoup de différence, donc la valeur partielle \(\eta^{2}\) pour la variable drug n’augmente pas beaucoup, et on obtient une valeur de \(_{p}\eta^{2} = 0,79\). En revanche, parce que l’effet de drug était très important, la prise en compte de l’effet de drug fait une grande différence, et donc lorsque nous calculons la valeur partielle de \(\eta^{2}\) pour la variable therapy, vous pouvez voir qu’elle s’élève à \(_{p}\eta^{2}=0,34\). La question que nous devons nous poser est la suivante : que signifient réellement ces valeurs partielles de \(\eta^{2}\) ? La façon dont j’interprète généralement le \(\eta^{2}\) partiel pour l’effet principal du facteur A est de l’interpréter comme un énoncé au sujet d’une expérience hypothétique dans laquelle seul le facteur A était modifié. Ainsi, même si, dans cette expérience, nous avons deux facteurs A et B, nous pouvons facilement imaginer une expérience dans laquelle seul le facteur A utilisé, et la statistique partielle \(\eta^{2}\) vous indique quelle part de la variance de la variable résultat que vous vous attendriez à voir prise en compte dans cette expérience. Cependant, il faut noter que cette interprétation, comme beaucoup de choses associées aux effets principaux, n’a pas beaucoup de sens lorsqu’il y a un effet d’interaction important et significatif.

En parlant d’effets d’interaction, voici ce que nous obtenons lorsque nous calculons la taille de l’effet pour le modèle qui inclut le terme d’interaction, comme dans la Figure 14‑7. Comme vous pouvez le voir, les valeurs de \(\eta^{2}\) pour les effets principaux ne changent pas, contrairement aux valeurs partielles de \(\eta^{2}\) :

14.3.1 Moyenne estimée du groupe

Dans de nombreuses situations, vous voudrez déclarer des estimations de toutes les moyennes de groupe en fonction des résultats de votre analyse de variance, ainsi que des intervalles de confiance qui y sont associés. Pour ce faire, vous pouvez utiliser l’option « Estimated Marginal Means » dans l’analyse ANOVA de Jamovi, comme dans la Figure 14‑8. Si l’analyse de variance que vous avez exécutée est un modèle saturé (c.-à-d. qu’elle contient tous les effets principaux possibles et tous les effets d’interaction possibles), les estimations des moyennes des groupes sont en fait identiques aux moyennes de l’échantillon, bien que les intervalles de confiance utilisent une estimation globale des erreurs types plutôt que des estimations distinctes pour chaque groupe.

Figure 14‑8 : capture d’écran de Jamovi montrant les moyennes marginales du modèle saturé, c’est-à-dire incluant la composante d’interaction, avec l’ensemble des données clinicaltrial

Les résultats montrent que le gain d’humeur moyen estimé pour le groupe placebo sans traitement était de 0,300, avec un intervalle de confiance à 95 % allant de 0,006 à 0,594. Il est à noter qu’il ne s’agit pas des mêmes intervalles de confiance que ceux que vous obtiendriez si vous les calculiez séparément pour chaque groupe, parce que le modèle ANOVA suppose l’homogénéité de la variance et utilise donc une estimation globale de l’écart type.

Lorsque le modèle ne contient pas le terme d’interaction, la moyenne estimée du groupe sera différente de la moyenne de l’échantillon. Au lieu de déclarer la moyenne de l’échantillon, Jamovi calculera la valeur de la moyenne du groupe à partir de la moyenne marginale (c.-à-d. en supposant qu’il n’y a aucune interaction). En utilisant la notation que nous avons développée précédemment, l’estimation rapportée pour\(\mu_{rc}\), la moyenne pour le niveau r sur le facteur A (ligne) et le niveau c sur le facteur B (colonne) serait \(u_{\text{..}} + \alpha_{r} + \beta_{c}\). S’il n’y a vraiment aucune interaction entre les deux facteurs, il s’agit en fait d’une meilleure estimation de la moyenne de la population que la moyenne brute de l’échantillon. La suppression du terme d’interaction du modèle, via les options « Model » de l’analyse ANOVA de Jamovi, fournit les moyennes marginales pour l’analyse présentée à la Figure 14‑9.

Figure 14‑9 : capture d’écran de Jamovi montrant les moyennes marginales du modèle insaturé, c’est-à-dire sans la composante interaction, avec l’ensemble des données clinicaltrial

14.4 Vérification des hypothèses

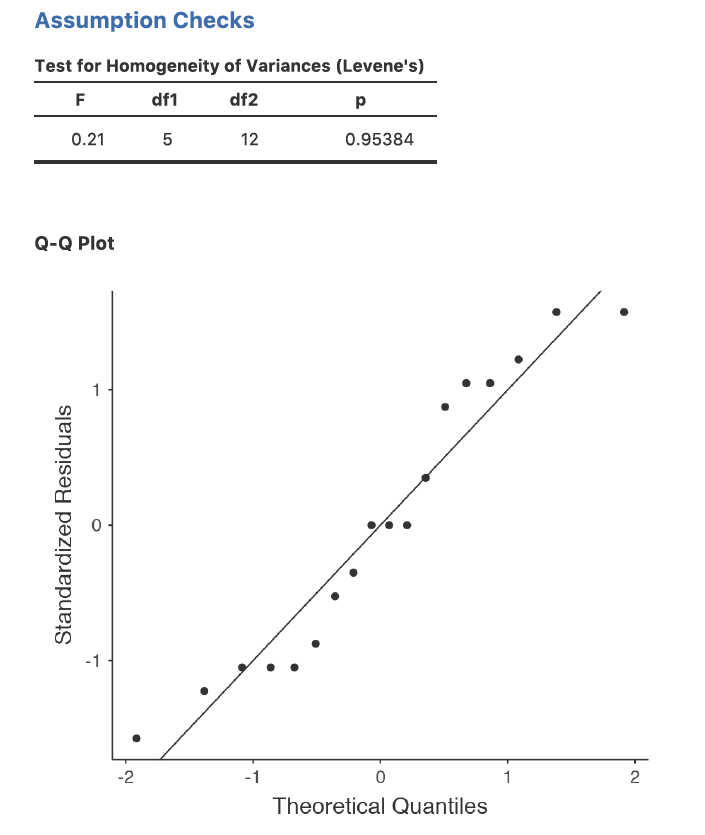

Comme pour l’analyse de variance à un facteur, les hypothèses clés de l’analyse de variance factorielle sont l’homogénéité de la variance (tous les groupes ont le même écart-type), la normalité des résidus et l’indépendance des observations. Les deux premiers sont des choses qu’on peut vérifier. La troisième est quelque chose que vous devez évaluer vous-même en vous demandant s’il y a des relations spéciales entre les différentes observations, par exemple des mesures répétées où la variable indépendante est le temps, de sorte qu’il y a une relation entre les observations au temps un et au temps deux : les observations à différents moments proviennent des mêmes personnes. De plus, si vous n’utilisez pas un modèle saturé (par exemple, si vous avez omis les termes d’interaction), vous supposez également que les termes omis ne sont pas importants. Bien sûr, vous pouvez vérifier cette dernière en exécutant une ANOVA avec les termes omis inclus et voir s’ils sont significatifs, c’est assez donc facile. Qu’en est-il de l’homogénéité de la variance et de la normalité des résidus ? Il s’avère que c’est assez facile à vérifier. Ce n’est pas différent des contrôles que nous avons effectués pour une ANOVA à un facteur.

14.4.1 Homogénéité de la variance

Comme nous l’avons mentionné à la section 13.6.1, il est bon d’inspecter visuellement un graphique des écarts-types comparés entre différents groupes ou catégories, et de voir si le test de Levene est conforme à l’inspection visuelle. La théorie qui sous-tend le test de Levene a été abordée à la section 13.6.1, de sorte que je n’en parlerai plus. Ce test s’attend à ce que vous ayez un modèle saturé (c.-à-d., incluant tous les éléments suivants les termes pertinents), parce que le test porte principalement sur la variance intra-groupe et qu’il n’est pas vraiment logique de calculer cela autrement que par rapport au modèle complet. Le test de Levene peut être spécifié dans le cadre de l’option de l’ANOVA « Assumption Checks » - « Homogeneity Tests » dans Jamovi, avec le résultat indiqué à la Figure 14‑10. Le fait que le test de Levene ne soit pas significatif signifie que, à condition qu’il soit cohérent avec une inspection visuelle du graphique des écarts-types, nous pouvons supposer avec certitude que l’hypothèse d’homogénéité de la variance n’est pas violée.

14.4.2 Normalité des résidus

Comme pour l’analyse de variance à sens unique, nous pouvons tester la normalité des résidus d’une manière simple et directe (voir la section 13.6.4). Cependant, c’est généralement une bonne idée d’examiner les résidus graphiquement à l’aide d’un graphe QQ. Voir la Figure 14‑10.

Figure 14‑10 : Vérification des présupposés dans un modèle d’ANOVA

14.5 Analyse de la covariance (ANCOVA)

Une variation de l’analyse de variance se produit lorsqu’il y a une variable continue supplémentaire qui, à votre avis, pourrait être liée à la variable dépendante. Cette variable supplémentaire peut être ajoutée à l’analyse en tant que covariable, dans l’analyse de covariance bien nommée (ANCOVA).

Dans ANCOVA, les valeurs de la variable dépendante sont « ajustées » pour tenir compte de l’influence de la covariable, puis les moyennes de score « ajustées » sont testées entre groupes de la manière habituelle. Cette technique peut augmenter la précision d’une expérience, et donc fournir un test plus « puissant » de l’égalité des moyennes de groupe pour la variable dépendante. Comment ANCOVA s’y prend-elle ? Bien que la covariable elle-même ne présente généralement aucun intérêt expérimental, l’ajustement pour la covariable peut diminuer l’estimation de l’erreur expérimentale et donc, en réduisant la variance de l’erreur, la précision est accrue. Cela signifie que rejeter l’hypothèse nulle de façon inappropriée (faux négatif ou erreur de type II) est moins probable.

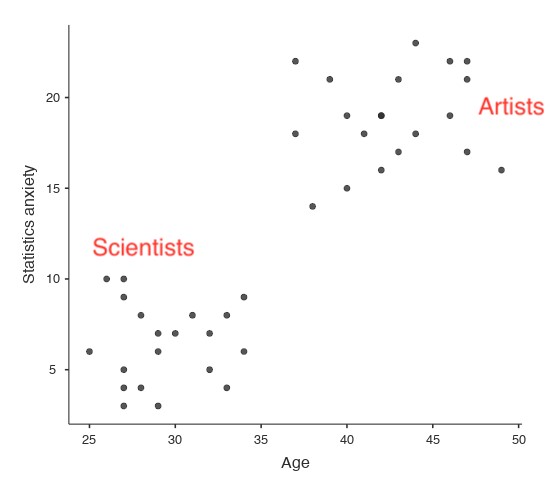

Malgré cet avantage, ANCOVA court le risque d’aplanir les différences réelles entre les groupes, ce qu’il faut éviter. Par exemple, regardez la Figure 14‑11, qui montre un graphique de l’aversion pour les statistiques par rapport à l’âge et dans deux groupes distincts - les élèves qui ont une formation ou une préférence en arts ou en sciences. ANCOVA avec l’âge comme covariable pourrait mener à la conclusion que l’anxiété statistique ne diffère pas entre les deux groupes. Cette conclusion serait-elle raisonnable - probablement pas parce que les âges des deux groupes ne se chevauchent pas et que l’analyse de la variance a essentiellement « extrapolé à une région sans données » (Everitt (1996), p. 68).

Figure 14‑11 : Représentation graphique de l’aversion aux statistiques par rapport à l’âge pour deux groupes distincts

De toute évidence, il faut réfléchir soigneusement à l’analyse de la covariance avec des groupes distincts. Ceci s’applique à la fois aux plans à un facteur et factorielles, car ANCOVA peut être utilisé avec les deux.

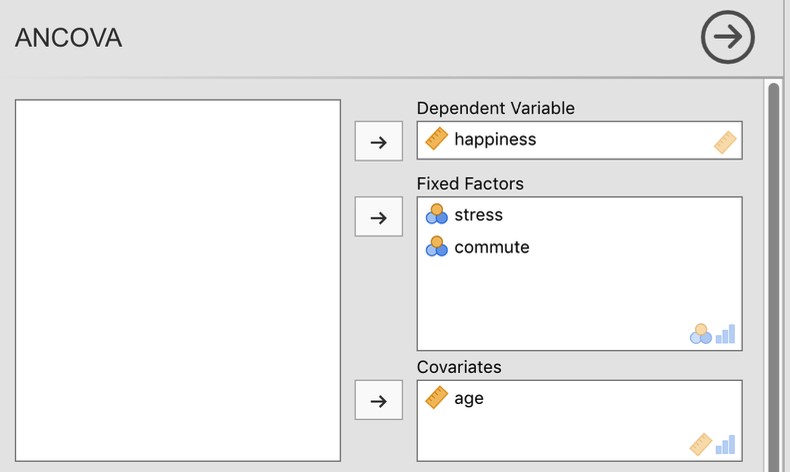

14.5.1 Exécuter ANCOVA en Jamovi

Un psychologue de la santé s’est intéressé à l’effet de l’utilisation habituelle du vélo et du stress sur les niveaux de bonheur, avec l’âge comme covariable. Vous pouvez trouver l’ensemble de données dans le fichier ancova.csv. Ouvrez ce fichier dans Jamovi et ensuite, pour entreprendre une ANCOVA, sélectionnez Analyses - ANOVA - ANCOVA pour ouvrir la fenêtre ANCOVA analysis (Figure 14‑12). Sélectionnez la variable dépendante « bonheur » et transférez-la dans la zone de texte « Dependant Variable ». Sélectionnez les variables indépendantes « stress » et « commute » et transférez-les dans la zone de texte « Fixed Factors ». Mettez en surbrillance la covariable « âge » et transférez-la dans la zone de texte « Covariables ». Cliquez ensuite sur Moyennes marginales estimées… pour afficher les options des graphiques et des tableaux.

Figure 14‑12 : La fenêtre d’analyse ANCOVA de Jamovi

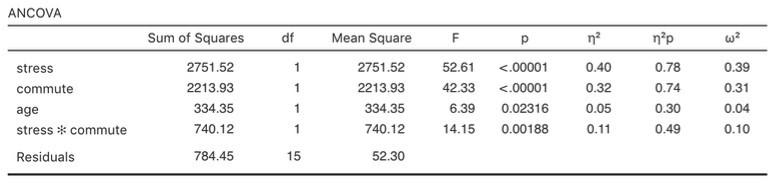

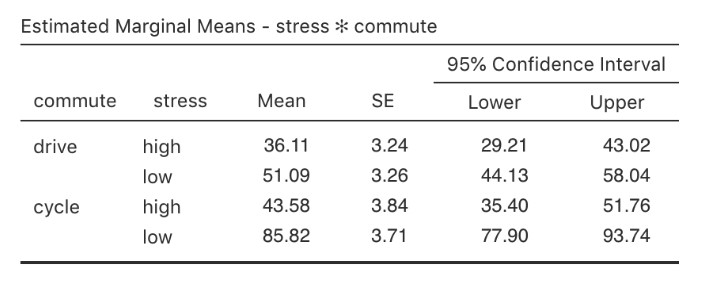

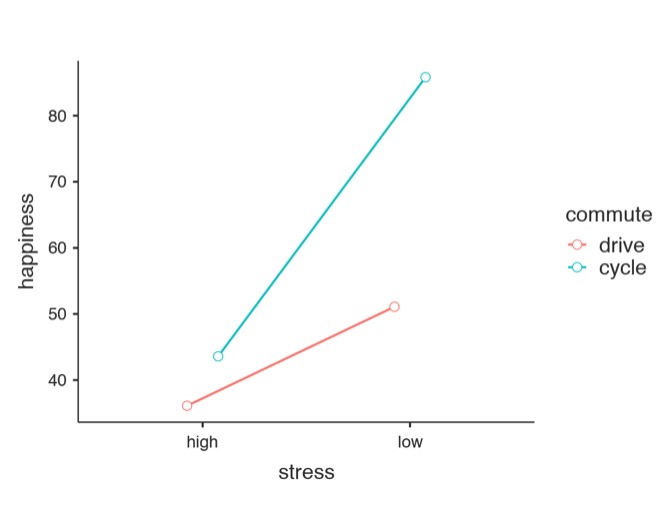

Un tableau ANCOVA montrant les tests sur les effets inter sujet est produit dans la fenêtre de résultats Jamovi (Figure 14‑13). La valeur F de la covariable « âge » est significative à p=.023, ce qui suggère que l’âge est un prédicteur important de la variable dépendante, le bonheur. Lorsque nous examinons les scores marginaux moyens estimés (Figure 14‑14), des ajustements ont été faits (par rapport à une analyse sans covariable) en raison de l’inclusion de la covariable « âge » dans cet ANCOVA. Un graphique (Figure 14‑15) est un bon moyen de visualiser et d’interpréter les effets significatifs.

La valeur F de l’effet principal « contrainte » (52,61) est associée à une probabilité de p<.001. La valeur F de l’effet principal « commute » (42,33) est associée à une probabilité de p<.001. Comme ces deux valeurs sont inférieures à la probabilité habituellement utilisée pour décider si un résultat statistique est significatif (p<.05), nous pouvons conclure qu’il y a eu un effet principal significatif du stress (F(1,15) = 52,61, p<.001) et un effet principal significatif de la méthode du transport quotidien (F(1,15) = 42,33, p<.001). Une interaction significative entre le stress et la mode de déplacement a également été trouvée (F(1,15) = 14,15, p=.002).

Figure 14‑13 : Résultats de l’ANCOVA dans Jamovi pour la variable bonheur (hapiness) en fonction du stress et du mode de déplacement (commute), avec l’âge comme covariable.

Figure 14‑14 : Tableau du niveau de bonheur moyen en fonction du stress et de la mode de déplacement (ajusté pour l’âge covarié) avec des intervalles de confiance à 95 %.

Dans la Figure 14‑15, nous pouvons voir les scores de bonheur ajustés, marginaux et moyens lorsque l’âge est une covariable dans une ANCOVA. Dans cette analyse, il existe un effet d’interaction significatif, selon lequel les personnes peu stressées qui se rendent au travail à vélo sont plus heureuses que les personnes peu stressées qui y vont en voiture et les personnes très stressées, qu’elles se rendent au travail à vélo ou en voiture. Il y a aussi un effet principal important du stress - les personnes peu stressées sont plus heureuses que celles qui sont très stressées. Et il y a aussi un effet principal important du comportement de déplacement domicile-travail - les gens qui font du vélo sont en moyenne plus heureux que ceux qui se rendent au travail en voiture.

Figure 14‑15 : Diagramme du niveau de bonheur moyen en fonction du stress et de la méthode de déplacement

Vous devez être attentif au fait que, si vous songez à inclure une covariable dans votre analyse de variance, il y a une hypothèse supplémentaire : la relation entre la covariable et la variable dépendante doit être semblable pour tous les niveaux de la variable indépendante. Ceci peut être vérifié par l’ajout d’un terme d’interaction entre la covariable et chaque variable indépendante dans les options de Jamovi « Model - Model terms ». Si l’effet d’interaction n’est pas significatif, il peut être supprimé. S’il est significatif, alors une technique statistique différente et plus avancée pourrait être appropriée (ce qui dépasse le cadre de ce livre et vous voudrez peut-être consulter un statisticien amical).

14.6 ANOVA comme modèle linéaire

L’une des choses les plus importantes à comprendre au sujet de l’analyse de variance et de la régression est qu’il s’agit essentiellement de la même chose. À première vue, on ne le croirait peut-être pas. Après tout, la façon dont je les ai décrites jusqu’à présent suggère que l’analyse de variance vise principalement à vérifier les différences entre les groupes et que la régression vise principalement à comprendre les corrélations entre les variables. Et, pour autant que je sache, c’est tout à fait vrai. Mais quand on regarde dans le moteur, pour ainsi dire, les mécanismes sous-jacents de l’analyse de variance et de la régression sont terriblement semblables. En fait, si vous y pensez, vous en avez déjà vu la preuve. L’analyse de variance et la régression reposent toutes deux fortement sur des sommes de carrés (SS), toutes deux font appel à des tests F, et ainsi de suite. Rétrospectivement, il est difficile d’échapper au sentiment que les chapitres 12 et 13 étaient un peu répétitifs.

La raison en est que l’analyse de variance et la régression sont deux types de modèles linéaires. Dans le cas de la régression, c’est un peu évident. L’équation de régression que nous utilisons pour définir la relation entre les prédicteurs et les résultats est l’équation d’une droite, donc c’est de toute évidence un modèle linéaire, avec l’équation suivante

\[ Y_{p} = b_{0} + b_{1}X_{1p} + b_{2}X_{2p} + \epsilon_{p} \]

où Yp est la valeur finale de la p-ième observation (c.-à-d., p-ième personne), X1p est la valeur du premier prédicteur de la p-ième observation, X2p est la valeur du deuxième prédicteur de la p-ième observation, les termes b0, b1 et b2 sont nos coefficients de régression, et \(\epsilon_{p}\) est le p-ième résidu. Si nous ignorons les résidus \(\epsilon_{p}\) et que nous nous concentrons sur la ligne de régression elle-même, nous obtenons la formule suivante :

\[ {\hat{Y}}_{p} = b_{0} + b_{1}X_{1p} + b_{2}X_{2p} \]

où \({\hat{Y}}_{p}\) est la valeur de Y que la ligne de régression prédit pour la personne p, par opposition à la valeur Yp réellement observée. Ce qui n’est pas immédiatement évident, c’est que nous pouvons aussi écrire ANOVA comme modèle linéaire. C’est en fait assez simple à faire. Commençons par un exemple très simple, en réécrivant une ANOVA factorielle 2 x 2 comme modèle linéaire.

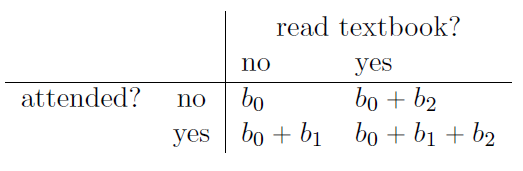

14.6.1 Quelques données

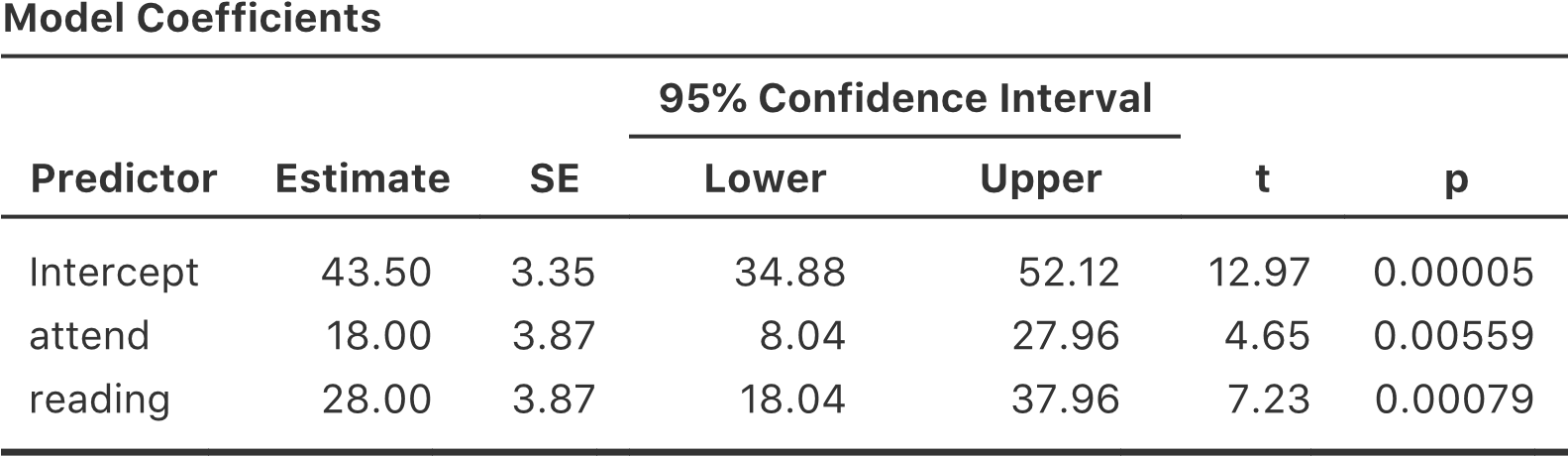

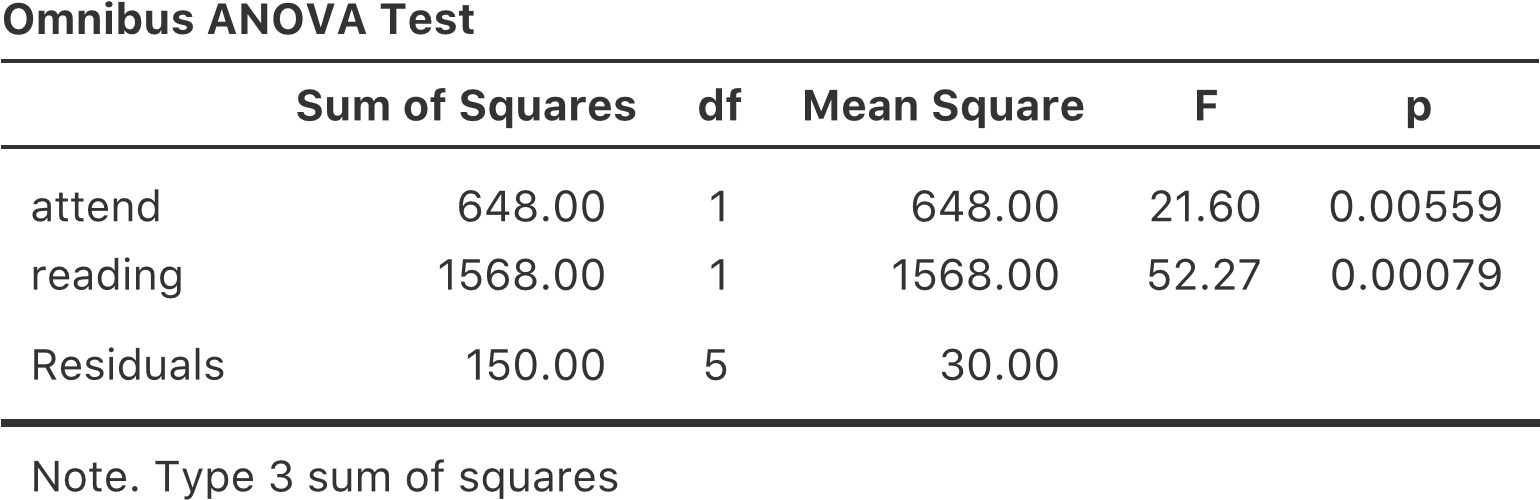

Pour concrétiser les choses, supposons que notre variable de résultat est la grade (note) qu’un élève reçoit dans mon cours, une variable sur une échelle de rapport correspondant à une note de 0% à 100%. Il y a deux variables prédictrices d’intérêt : si l’étudiant s’est présenté aux cours (la variable attend (fréquentation)) et si l’étudiant a lu ou non le manuel (la variable reading (lecture)). Nous dirons que attend=1 si l’élève a assisté au cours, et de 0 s’il n’y a pas assisté. De même, nous dirons que reading = 1 si l’élève a lu le manuel, et reading = 0 s’il ne l’a pas lu.

Bien, pour l’instant c’est assez simple. La prochaine chose que nous devons faire est d’enrober cela d’un peu de maths (désolé !). Pour les besoins de cet exemple, supposons que Yp indique la note du cinquième élève de la classe. Ce n’est pas tout à fait la même notation que celle que nous avons utilisée plus tôt dans ce chapitre. Auparavant, nous avons utilisé la notation Yrci pour désigner la i-ème personne du r-ème groupe pour le prédicteur 1 (le facteur de ligne) et le c-ème groupe pour le prédicteur 2 (le facteur de colonne). Cette notation générale était vraiment pratique pour décrire le calcul des SS, mais c’est une souffrance dans le contexte actuel, alors je vais changer de notation ici. Maintenant, la notation Yp est visuellement plus simple que Yrci, mais elle a le défaut de ne pas garder la trace des membres du groupe ! C’est-à-dire, si je vous disais que Y0,0,3=35, vous sauriez immédiatement qu’il s’agit d’un étudiant (le 3e de ce type, en fait) qui n’a pas assisté aux cours (c.-à-d., attend=0) et n’a pas lu le manuel (c.-à-d., reading=0), et qui a échoué en cours (Grade=35). Mais si je vous dis que Yp=35, tout ce que vous savez, c’est que le p-ième étudiant n’a pas eu une bonne note. Nous avons perdu des informations clés. Bien sûr, il ne faut pas beaucoup de réflexion pour comprendre comment régler ce problème. Ce que nous allons faire à la place est d’introduire deux nouvelles variables X1p et X2p qui gardent la trace de ces informations. Dans le cas de notre étudiant hypothétique, nous savons que X1p=0 (c.-à-d., attend = 0) et X2p=0 (c.-à-d., reading=0). Les données pourraient donc ressembler à ceci :

| personne, p | grade, Yp | attendance, *X~1p |

~* | lecture, X2p |

| 1 | 90 | 1 | 1 |

| 2 | 87 | 1 | 1 |

| 3 | 75 | 0 | 1 |

| 4 | 60 | 1 | 0 |

| 5 | 35 | 0 | 0 |

| 6 | 50 | 0 | 0 |

| 7 | 65 | 1 | 0 |

| 8 | 70 | 0 | 1 |

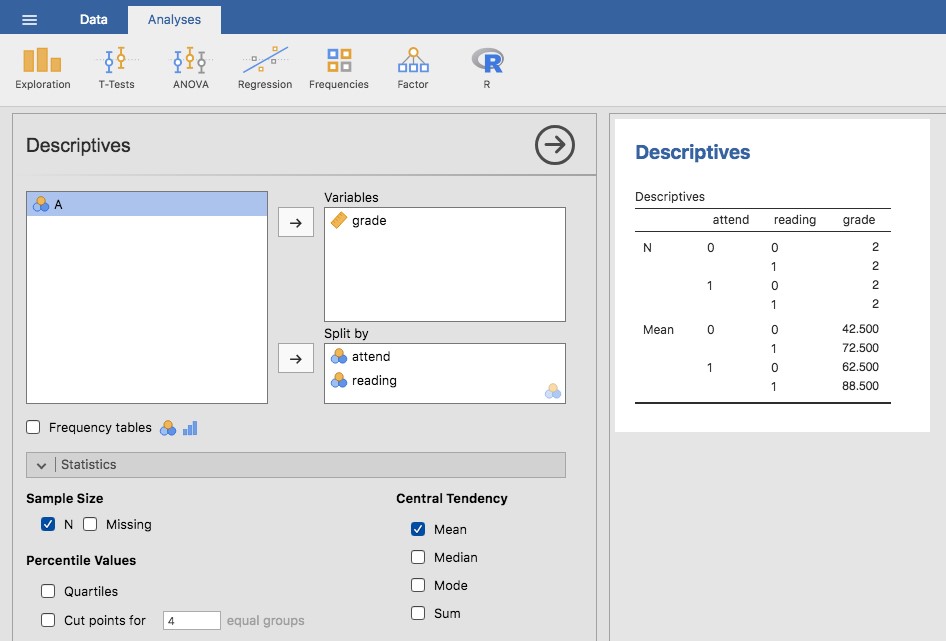

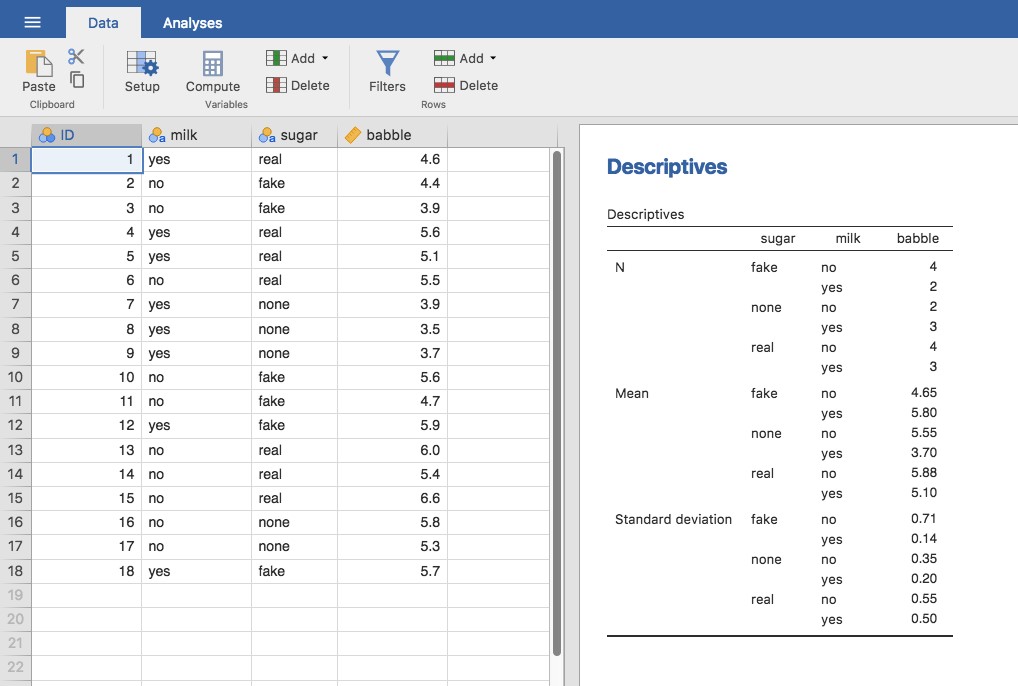

Il n’y a rien de particulier, bien sûr. C’est exactement le format dans lequel nous nous attendons à voir nos données ! Voir le fichier rtfm.csv. Nous pouvons utiliser l’analyse « Descriptives » de Jamovi pour confirmer que cet ensemble de données correspond à un plan équilibré, avec 2 observations pour chaque combinaison de attend et de read. De la même manière, nous pouvons également calculer la note moyenne pour chaque combinaison. C’est ce que montre la Figure 14‑16. En regardant les notes moyennes, on a la forte impression que la lecture du texte et le fait d’assister aux cours sont très importants.

Figure 14‑16: Statistiques descriptives dans Jamovi pour l’ensemble de données rtfm.csv

14.6.2 ANOVA avec des facteurs binaires comme modèle de régression

Bien, revenons aux mathématiques. Nous avons maintenant nos données exprimées avec trois variables numériques : la variable continue Y et les deux variables binaires X1 et X2. Ce que je veux que vous reconnaissiez, c’est que notre ANOVA factorielle 2x2 est strictement équivalente au modèle de régression.

\[ Y_{p} = b_{0} + b_{1}X_{1p} + b_{2}X_{2p} + \epsilon_{p} \]

Bien sûr, c’est exactement la même équation que celle que j’ai utilisée plus tôt pour décrire un modèle de régression à deux prédicteurs ! La seule différence est que X1 et X2 sont maintenant des variables binaires (c.-à-d. que les valeurs ne peuvent être que 0 ou 1), alors que dans une analyse de régression, nous prévoyons que X1 et X2 seront continues. Il y a deux ou trois façons dont je pourrais essayer de vous en convaincre. Une possibilité serait de faire un long exercice mathématique pour prouver que les deux sont identiques. Cependant, je vais anticiper et deviner que la plupart des lecteurs de ce livre trouveront cela ennuyeux plutôt qu’utile. Au lieu de cela, j’expliquerai les idées de base et je m’appuierai sur Jamovi pour montrer que les analyses ANOVA et les analyses de régression ne sont pas seulement similaires, elles sont identiques. Commençons par faire une analyse de variance. Pour ce faire, nous utiliserons l’ensemble de données rtfm.csv, et regardons la Figure 14‑17 qui montre ce qu’on obtient quand on fait l’analyse à Jamovi.

Figure 14‑17 : ANOVA de l’ensemble de données rtfm.csv dans Jamovi, sans le terme d’interaction

En lisant les chiffres clés du tableau de l’ANOVA et les scores moyens que nous avons présentés plus haut, nous pouvons voir que les élèves ont obtenu une meilleure note s’ils ont suivi la classe (F(1,5)=21,6, p=.0056) et s’ils lisent le manuel (F(1,5)=52.3, p=.0008). Notons ces valeurs p et ces statistiques F.

Pensons maintenant à la même analyse dans une perspective de régression linéaire. Dans l’ensemble de données rtfm.csv, nous avons encodé attend et la read comme s’il s’agissait de prédicteurs numériques. Dans ce cas, c’est tout à fait acceptable. Il y a vraiment un sens au fait qu’un étudiant qui se présente en classe (c.-à-d. attend = 1) a en fait « plus de présence » qu’un étudiant qui ne le fait pas (c.-à-d. attend = 0). Il n’est donc pas du tout déraisonnable de l’inclure comme prédicteur dans un modèle de régression. C’est un peu inhabituel, car le prédicteur ne prend que deux valeurs possibles, mais il ne viole aucune des hypothèses de la régression linéaire. Et c’est facile à interpréter. Si le coefficient de régression est supérieur à 0, cela signifie que les étudiants qui assistent à des cours ont des notes plus élevées. Si elle est inférieure à zéro, les étudiants qui assistent à des cours magistraux obtiennent des notes moins élevées. Il en va de même pour notre variable de read.

Attendez une seconde. Pourquoi est-ce vrai ? C’est quelque chose qui est intuitivement évident pour tous ceux qui ont suivi quelques cours de statistiques et qui sont à l’aise avec les mathématiques, mais ce n’est pas clair pour tout le monde au premier abord. Pour comprendre pourquoi c’est vrai, il est utile d’examiner de près quelques élèves en particulier. Commençons par considérer les 6e et 7e élèves de notre ensemble de données (c.-à-d. p = 6 et p = 7). Ni l’un ni l’autre n’a lu le manuel, de sorte que dans les deux cas, nous pouvons fixer read à 0, ou, pour dire la même chose dans notre notation mathématique, nous observons X2,6=0 et X2,7=0, mais l’étudiant numéro 7 est venu aux cours (c’est à dire attend = 1, X1,7=1) tandis que l’étudiant numéro 6 ne l’est pas (c’est-à-dire attend=0, *X1,6=0). Voyons maintenant ce qui se passe lorsque nous insérons ces nombres dans la formule générale de notre ligne de régression. Pour l’élève numéro 6, la régression prédit que

\[\begin{aligned} \hat{Y}_{6} &= b_{0} + b_{1}X_{1,6} + b_{2}X_{2,6}\\ &= b_{0}+\left( b_{1} \times 0 \right) + \left( b_{2} \times 0 \right)\\ &= b_{0} \end{aligned} \]

On s’attend donc à ce que cet élève obtienne une note correspondant à la valeur du terme d’intersection b0. Et l’élève 7 ? Cette fois, lorsque nous insérons les nombres dans la formule de la ligne de régression, nous obtenons ce qui suit

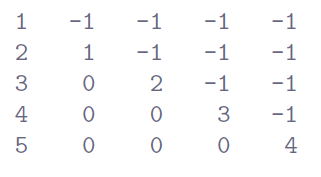

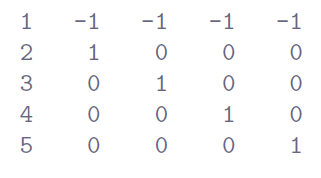

\[\begin{aligned} \hat{Y}_{7} &= b_{0} + b_{1}X_{1,7} + b_{2}X_{2,7}\\ &= b_{0}+\left( b_{1} \times 1 \right) + \left( b_{2} \times 0 \right)\\ &= b_{0} + b_{1} \end{aligned} \]